DeepMind表示要给人工智能增加想象力?我们来仔细看看吧 原创

至顶网软件频道消息:因击败世界顶尖围棋选手而名声大噪的谷歌人工智能精品店——DeepMind以消灭人类在智力方面的优越感妄想而著称,发现为其软件代理注入想象力有助于它们更好地学习。

本周发表的两篇论文——《Imagination-Augmented Agents for Deep Reinforcement Learning》和《Learning model-based planning from scratch》(从头开始基于模型的规划)——总部在英国人工智能业务的研究人员描述了通过想象力规划提升深度强化学习的新奇技术。

强化学习是机器学习的一种形式。它包含了通过与特定环境进行交互而学习的软件代理程序,通常通过反复尝试和犯错。深度学习是一种机器的形式,涉及受到人类大脑启发的算法——被称为神经网络。而这两种技术可以一起使用。

可以使用包含软件代理运行规则的模型来完成深层强化学习。例如,为了教会软件如何玩视频游戏,研究人员可能希望提供一个包含游戏信息的模型,这样可以避免在学习过程中代价高昂的尝试和犯错。或者研究人员可能会选择无模型的强化学习,期望软件代理最终自己选择游戏。

每种方法都有自身的缺点,基于模型的方法缺少在模型中未捕获的信息,而无需模型的方法需要大量数据集并且缺乏行为灵活性。DeepMind的工作尝试融合这两种方法的优点。

这些研究人员在他们的第一篇论文中解释说:“对环境模型的结构和可能存在的缺陷没有做出任何假设,我们的方法是以端对端的方式学习提取从模型模拟中收集的有用知识——特别不依赖于模拟的回报。”他们表示,“这样就可以让代理受益于基于模型的想象,而又不会陷入传统基于模型方式的陷阱。”

他们正在描述的是能够在行动之前思考的软件。

死胡同

DeepMind的研究人员提出通过构建,评估和执行计划来学习的软件代理。它将试错学习与模拟结合作为“飞行前”检查的一种形式,以便评估最有希望的途径,同时避免明显的死胡同。

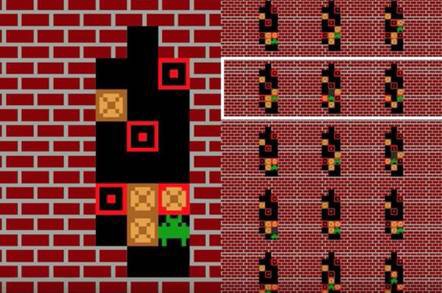

研究人员用Sokoban测试了他们的想象力代理,这是一个拼图视频游戏,是1981年在日本创建的,其中包含了在仓库里移动盒子以及飞船导航游戏。

Sokoban允许玩家推盒子,但是不可以拉动盒子,这意味着可能会有一些动作会让游戏中的难题无法解决。因此,如果是人类玩家,游戏就会建议他们在开始行动之前先制订一个计划。研究人员认为,因为DeepMind代理也能够进行这样的规划,所以也非常适合这个游戏。

想象代理设法解决了所提出的Sokoban中85%的关卡,而标准无模型代理则为只能完成60%。它的表现也超过了一个拷贝模型代理,这是一个不使用有想象规划增强版的标准代理。

研究人员在一篇博客中解释说:“对于这两个任务来说,想象增强代理在很大程度上胜过无想象的基准:它们以较少的经验学习,能够处理环境建模的缺陷。”他们表示,“因为代理能够从内部模拟中提取更多的知识,和传统的搜索方法——例如蒙特卡洛树搜索——相比,它们能够使用更少的想象,完成更多的任务。”

在行动之前思考让机器学习工作变得更慢,但研究人员认为:“这在不可逆转的领域至关重要,在这些环境中某些行动可能会产生灾难性的后果,例如Sokoban。”

好文章,需要你的鼓励

ServiceNow斥资10亿美元收购Veza 加速智能体权限管理

ServiceNow宣布将以超过10亿美元收购身份安全平台Veza,这是该公司2025年一系列AI和数据重点收购的最新举措。此次收购正值企业加速部署AI代理之际,而如何管理这些非人类身份的访问权限和输出已成为普遍难题。该交易将为ServiceNow的AI控制塔提供关键的身份治理能力,帮助企业建立统一的控制平面来定义上下文相关的权限、监控代理行为并大规模执行最小权限访问策略。

字节跳动发布GAR:让AI能像人类一样精准理解图像任何区域的突破性技术

字节跳动等机构联合发布GAR技术,让AI能同时理解图像的全局和局部信息,实现对多个区域间复杂关系的准确分析。该技术通过RoI对齐特征重放方法,在保持全局视野的同时提取精确细节,在多项测试中表现出色,甚至在某些指标上超越了体积更大的模型,为AI视觉理解能力带来重要突破。

除英伟达和台积电外,其他AI公司都需要靠量补利

在生成式AI热潮中,只有英伟达和台积电真正赚到钱,其他AI产业链公司要么亏损要么利润被稀释。博通虽然在数据中心网络领域有不错的利润率,但为了不被AI浪潮抛弃,也选择进入AI业务。博通拥有730亿美元的AI积压订单,但被迫成为AI系统集成商,进一步稀释利润。第四季度博通收入180亿美元,同比增长28.2%,AI芯片收入达65亿美元。

Inclusion AI推出万亿参数思维模型Ring-1T:首个开源的超大规模推理引擎如何重塑AI思考边界

Inclusion AI团队推出首个开源万亿参数思维模型Ring-1T,通过IcePop、C3PO++和ASystem三项核心技术突破,解决了超大规模强化学习训练的稳定性和效率难题。该模型在AIME-2025获得93.4分,IMO-2025达到银牌水平,CodeForces获得2088分,展现出卓越的数学推理和编程能力,为AI推理能力发展树立了新的里程碑。

除英伟达和台积电外,其他AI公司都需要靠量补利

2025年数据中心芯片领域最热门发展趋势

自动化技术领导者揭示企业对AI认知的关键误区

五分之三企业对Wi-Fi投资信心增强

CIO部署新兴技术指南:Gartner三步法平衡风险与收益

埃森哲与Anthropic合作引领AI集成商崛起之路

Pure Storage和华为存储增长最快,IDC第三季度报告显示

英特尔或以16亿美元收购AI推理芯片初创公司SambaNova

5D记忆晶体将成为未来数据存储主流技术

首届全国独角兽企业大赛总决赛在甬顺利闭幕

为全天候绿电而生,海辰储能发布全球首个原生8小时长时储能解决方案

为AI+而生,海辰储能发布全球首款锂钠协同AIDC全时长储能解决方案