微软推出“实时人工智能”平台 将使Azure变为“人工智能云” 原创

8月22日,微软再次推出其针对实时人工智能的Brainwave深度学习加速平台。而微软正在逐步曝光其将深度学习平台带入可定制芯片的计划和细节,这将使Azure成为“人工智能云”。

微软至少在2016年就曾经好几次谈过Brainwave。这一次,Brainwave的推出出现在本周的Hot Chips 2017大会上。

Brainwave由高性能分布式系统架构构成,运行在被称为现场可编程阵列(FPGA)的可定制芯片上的硬件深层神经网络引擎之上,微软今天在Research博客文章中表示,其中还包括一个用于部署在受过训练的模型编译器。

如同个月在博客文章中提到的,根据微软在2016年推出的可配置云计划,Brainwave是运行在基于FPGA硬件微服务的深度学习平台。演示提到了数据中心或互联网上的“硬件加速即服务”(Hardware Acceleration as a Service)。Brainwave分布式神经网络模型可以按照需要跨越多个FPGA。

此外,微软计划七月份在公司最近于雷德蒙德举办的Faculty Research Summit上讨论Brainwave,但是最终改变了主意。

在Hot Chips 2017大会上,微软的官员们表示,使用英特尔新的Stratix-10芯片,Brainwave在没有批处理的情况下实现了39.5兆次运算的持续性能。微软认为:Brainwave将使Azure用户能够在这种级别的性能下运行复杂的深度学习模型。

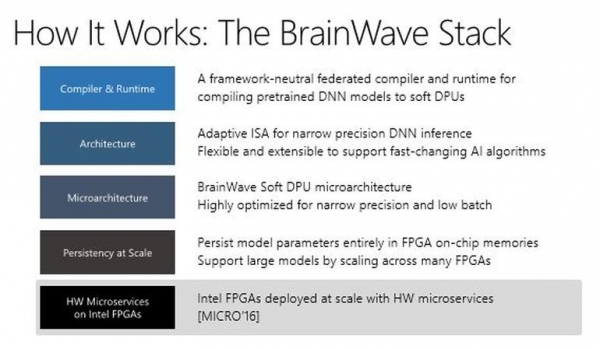

这是微软在Hot Chips大会上演示文稿中的新架构图,它显示了Brainwave的组件:

微软正在寻求在硬件微服务器上运行的Brainwave,推动受到部署在云端人工智能影响的服务边界,包括计算机视觉、自然语言处理和语音。

微软表示,他们将在2018年内通过Azure为外部开发人员提供FPGA。而微软并不是唯一一家在自己的云数据中心期待FPGA的公司,目前亚马逊和谷歌都在使用定制硅完成人工智能任务。

好文章,需要你的鼓励

更高负载、更快建设:2026年数据中心六大趋势

随着人工智能和高性能计算持续推动需求增长,数据中心设计正以同样惊人的速度演进。曾经的高密度机架已成为标准配置,冷却系统在数月而非数年内完成重新设计,项目在各地区的规模和复杂性不断提升。全球工程设计咨询公司Black & White Engineering指出,液冷成为标准配置、极端机架密度管理、工业化规模交付、电网约束下的电力创新、AI驱动运营设计以及可持续性成为核心设计原则,将成为2026年塑造数据中心设计、建设和运营的六大关键趋势。

让任何视频都能“讲述“自己的故事:ByteDance研究团队如何用轨迹场重新定义4D视频理解

这项由ByteDance Seed、香港科技大学等机构联合完成的研究提出了"轨迹场"这一创新的4D视频表示方法。研究团队开发的Trace Anything系统能够在单次前向传递中为视频中的每个像素预测连续的三维轨迹,无需光流估计或迭代优化。通过构建大规模合成数据平台和精心设计的训练方案,该方法在轨迹估计基准上实现了最先进性能,同时推理速度比竞争方法快10倍以上,并展现了运动预测、时空融合等多种涌现能力。

Snowflake数据库更新引发全球大规模服务中断

Snowflake本周推送的一次更新导致全球范围内的"重大故障",用户长达13小时无法查询数据、文件导入失败并收到错误信息。初步调查显示,最新版本引入了不向后兼容的数据库架构更新,导致版本不匹配错误。此次故障影响了全球23个区域中的10个,包括美国、欧洲和亚洲多个数据中心。这是Snowflake一周内第二次发生事故。

伊斯法罕大学研究团队揭秘:AI教育应用如何在数字化教学时代赢得用户青睐

伊斯法罕大学研究团队通过分析Google Play商店21款AI教育应用的用户评论,发现作业辅导类应用获得超80%正面评价,而语言学习和管理系统类应用表现较差。用户赞赏AI工具的快速响应和个性化指导,但抱怨收费过高、准确性不稳定等问题。研究建议开发者关注自适应个性化,政策制定者建立相关规范,未来发展方向为混合AI-人类模型。

Snowflake数据库更新引发全球大规模服务中断

AI编程初创公司Lovable融资3.3亿美元,英伟达等科技巨头支持

存储集成问题如何破坏基础设施自动化

英国政府机构发布报告:AI安全防护措施正在改善

2026年智能体AI:应用参差不齐而非全面普及

沙特STC与爱立信签署五年网络升级协议

# React2Shell漏洞利用蔓延,微软称数百台设备已遭入侵

# SanDisk开源技术将超大容量SSD测试速度提升90%

美光凭HBM需求激增创季度营收纪录

MaaS市场权威报告:阿里云获5项最高评级,为中国第一

几分钟完成3D渲染?HP ZBook Fury G1i 移动工作站让AI设计流程真正落地了

火山引擎:AI不再只是技术潜力,Agent成为下一个战场