谷歌云新增Nvidia GPU为机器学习提速 原创

至顶网软件频道消息:Google宣布在多个地区上线新的Nvidia GPU,希望以此更多用户在Google云中运行他们的机器学习和人工智能工作负载。

专用的云GPU(例如Nvidia开发的GPU)旨在加速机器学习训练和推理、地球物理数据处理、模拟、地震分析和分析建模等工作负载。

Google Compute Engine产品经理Chris Kleban和Ari Liberman在近日的一篇博客文章中表示,Google已经宣布开始测试Nvidia的P100 GPU。此外据称Nvidia的K80 GPU现在也已经出货了。他们补充说,Google将在这些GPU上提供“持续使用折扣”,以鼓励客户利用这些GPU。

说到Nvidia的Tesla P100 GPU,Google将其描述为“最先进的”处理器,允许客户以更少的实例提升吞吐量,同时节约成本。

Google还指出了云GPU与传统GPU相比的一些优点,首先就是提高了灵活性,因为这种GPU可让从中央处理器到内存再到磁盘大小和GPU配置的方方面面都可定制化,以满足客户的需求。

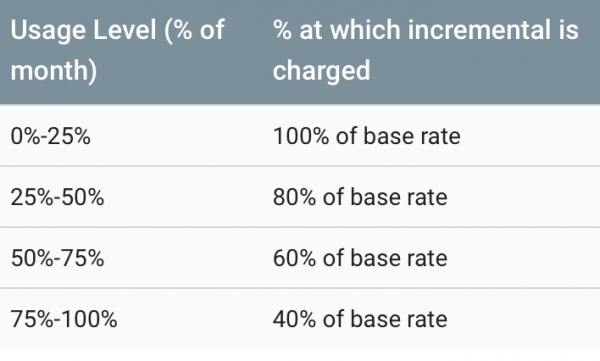

其次,就是云GPU可提高性能,以及降低成本,因为下图详细列举的持续使用折扣。最后,Google还强调了一个优点“云集成”,并称现在Google云堆栈的所有层面都提供了云GPU。

两位工程师这样写到:“对于基础设施来说,Compute Engine和Google Container Engine让你可以对虚拟机或者容器运行你的GPU工作负载。对于机器学习来说,Cloud Machine Learning可以选配GPU以缩短利用TensorFlow大规模训练模型的时间。”

Google还补充说,新增的GPU将在率先4个地区提供,包括美国东部、美国西部、欧洲西部和亚洲东部。

Google表示,看到了一些客户在一系列计算密集型任务中使用新的GPU,包括基因组学、计算金融和机器学习模型训练。Google表示,两种不同芯片的选择为客户提供了更多的灵活性,因为客户可以选择最合适的芯片来优化他们工作负载、同时平衡性能与定价。

好文章,需要你的鼓励

为何MCP服务器已成为关键微服务架构组件

模型上下文协议(MCP)服务器是连接概率性大语言模型和确定性微服务工作流的关键节点,充当推理引擎与外部数据工具的翻译层。在生产环境中部署AI智能体时,MCP服务器承担着定义智能体能力、管理上下文数据和执行操作三大核心职责。由于其非确定性客户端特性,传统单元测试无法有效验证,需要通过端到端测试来确保系统可靠性,这使得MCP服务器成为智能体架构中不可或缺的关键基础设施。

UCSD团队打造终极仿真世界:让AI智能体在虚拟城市中自立更生的惊人实验

SimWorld是由UCSD等多所顶尖院校联合开发的革命性AI仿真平台,基于虚幻引擎5构建了具备真实物理规律的虚拟城市环境。该平台支持无限扩展的程序化世界生成和自然语言交互,让AI智能体能够在复杂环境中学会生存、合作和竞争,为通用人工智能的发展提供了前所未有的训练平台。

英伟达发布Vera Rubin架构,专为AI智能体设计

英伟达推出Vera Rubin计算平台,专为驱动具备思考和推理能力的智能AI系统而设计。该平台采用NVL72液冷机架系统,集成六种芯片包括新Vera CPU和Rubin GPU。相比Blackwell架构,Rubin GPU推理速度提升5倍,训练速度提升3.5倍。平台还推出推理上下文内存存储解决方案,性能提升5倍。此外,英伟达还发布了面向自动驾驶的开源Alpamayo模型系列。

浙江大学团队提出C2DLM:让AI推理更像人类思维的全新语言模型

浙江大学联合华为提出C2DLM,这是一种因果概念引导的扩散语言模型,通过自动提取因果关系并融入注意力机制来增强AI推理能力。相比传统方法,C2DLM在推理任务上平均提升1.31%-12%,训练效率提高3.2倍,为解决语言模型推理能力不足开辟了新路径。

全新软件与模型优化为 NVIDIA DGX Spark 注入强大动力

NVIDIA DGX Spark 为桌面端最新开源与前沿AI模型提供强大算力支持

AI流量激增为何现在就需要光网络自动化

AMD 推出锐龙 AI 嵌入式处理器产品组合,为汽车、工业和物理 AI 领域提供 AI 驱动的沉浸式体验

Kubernetes推出AI一致性认证计划,VMware率先通过认证

为何MCP服务器已成为关键微服务架构组件

英伟达发布Vera Rubin架构,专为AI智能体设计

富士通前支持团队被称为"合法黑客"

AI承诺减少繁重工作却可能增加复杂性和压力

TCL推出首款HDR智能显示眼镜,画面效果令人印象深刻

亚马逊首款彩色电子阅读器Kindle Colorsoft降价50美元

惠普OmniBook笔记本全新设计搭载OLED显示屏