OpenAI发布可加速GPU机器学习的核心工具库 原创

至顶网软件频道消息: OpenAI研究人员日前发布了一个工具库,该工具库可以帮助研究人员在GPU上建立更快、更高效、占内存更少的神经网络。

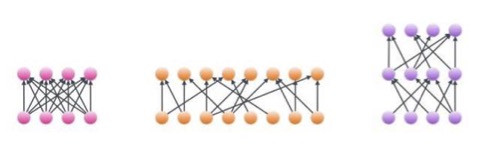

神经网络由一些连接节点层组成。神经网络的结构处决于数据和应用程序,各种结构的变化可以很大,但所有的模型都受到GPU运行方式的限制。

一种使用较小的计算达到训练较大模型的方法是使用稀疏矩阵。如果一个矩阵里大多数元素都是零,该矩阵即为稀疏矩阵。矩阵的空白元素(零)可以被压缩,在做矩阵乘法时可以跳过这些元素,而且,稀疏矩阵占用的GPU内存较少。

OpenAI的研究科学家Durk Kingma在向记者解释时表示,矩阵运算时的计算成本与矩阵中非零项的数量成正比。

使用稀疏矩阵就意味着节省下来的额外计算可用于构建横向更宽或纵向更深的网络,从而可以更高效地训练和执行推导运算,比率可高达十倍。

通过增加稀疏性后,密集神经网络(左)可以变成更宽(中)或更深(右)神经网络。 (图片来源:OpenAI)

Kingma表示,Nvidia其实并不支持稀疏模型。OpenAI的一个团队因此决定为广泛的研究社区开发核心程序(一种编译在硬件上运行的软件的小程序),核心程序是针对构建块状稀疏网络优化过的。

Elon Musk的人工智能研究部门的研究人员在内部利用OpenAI的核心程序训练长期短期记忆神经网络,这些神经网络被用于亚马逊和IMDB上评论文章的情绪分析。

研究人员在提交准备发表的文章(https://blog.openai.com/unsupervised-sentiment-neuron/)里表示,“我们的稀疏模型改善了文档级IMDB数据集截止目前为止的最好结果,由原来的5.91%错误率提高到5.01%。该改善结果与我们之前的结果比表现出了其潜力,原来的方法只有在处理短句层次文档时才能达到最佳效果。”

该核心程序是用CUDA编写的,OpenAI目前只为其开发了一个TensorFlow包装器,使用别的框架的研究人员需编写自己的包装器。还有,该核心程序仅支持Nvidia GPU。

Open AI的技术人员Scott Gray告诉记者,“该核心程序肯定可以扩展到其他支持小块矩阵乘法的架构,包括我知道的大多数架构,不过不包括Google的TPU2。“

Kingma说,尽管这些结果很有潜力,但“由于核心程序是新开发的,我们并不是明确知道核心程序在什么时候以及什么地方可以帮助神经网络架构。在实验中,我们提供了一些有助于在模型里添加稀疏性的例子。我们鼓励社区进一步探索这个空间。“

Gray做了补充,他表示,Nvidia已经获悉核心程序方面的工作,他们正在等代码发布后进一步提供更广泛的支持。

OpenAI的工作与Taco类似。Taco是由麻省理工学院的研究人员创建的一个软件,可自动生成处理稀疏矩阵的代码。

好文章,需要你的鼓励

英伟达Vera-Rubin平台推出前六月已淘汰现有AI硬件

英伟达在2026年消费电子展上发布Vera-Rubin NVL72机架级系统,该系统配备72个GPU插槽和36个CPU插槽,相比前代Grace-Blackwell NVL72系统,在专家混合AI模型推理成本降低10倍,训练所需GPU数量减少4倍。新系统采用Rubin GPU和Vera Arm CPU,HBM4内存带宽达22TB/秒,较前代提升2.75倍。预计2026年下半年开始量产,标志着AI硬件性能的重大突破。

UCSD团队打造终极仿真世界:让AI智能体在虚拟城市中自立更生的惊人实验

SimWorld是由UCSD等多所顶尖院校联合开发的革命性AI仿真平台,基于虚幻引擎5构建了具备真实物理规律的虚拟城市环境。该平台支持无限扩展的程序化世界生成和自然语言交互,让AI智能体能够在复杂环境中学会生存、合作和竞争,为通用人工智能的发展提供了前所未有的训练平台。

英特尔推出首批18A工艺制程的Core Ultra处理器

英特尔在CES展会上发布了Core Ultra X9和X7处理器,这是首批采用其最先进18A制程技术的芯片。这些处理器属于全新的18A Panther Lake Core Ultra Series 3系列,将被众多顶级PC制造商采用。18A制程相当于1.8纳米,性能功耗比提升15%,单线程性能比Lunar Lake芯片高出10%,多线程性能提升超50%。搭载该处理器的笔记本电脑将于本月底全球发布。

浙江大学团队提出C2DLM:让AI推理更像人类思维的全新语言模型

浙江大学联合华为提出C2DLM,这是一种因果概念引导的扩散语言模型,通过自动提取因果关系并融入注意力机制来增强AI推理能力。相比传统方法,C2DLM在推理任务上平均提升1.31%-12%,训练效率提高3.2倍,为解决语言模型推理能力不足开辟了新路径。

英伟达Vera-Rubin平台推出前六月已淘汰现有AI硬件

英特尔推出首批18A工艺制程的Core Ultra处理器

Rokid在CES 2026推出无屏AI智能眼镜

英伟达物理AI模型为新一代机器人铺路

微软发布 GitHub Copilot 的 C++ 代码编辑工具

至顶AI实验室硬核评测:戴尔Precision 5690移动工作站,部署DeepSeek+LobeChat打造个人超级智能体

让AI自己教自己写代码,会发生什么?

看得见的未来:2026年AI数据中心的革新之路

AI智能宠物健康监测站:竟说我是生病的猫

CES 2026最佳科技产品盘点:三折手机与超薄电视

亚马逊Alexa+向公众开放早期体验网站

Infinidat创始人破产问题影响联想收购进程