英特尔BigDL:让大数据与深度学习不分家 原创

至顶网软件频道消息:继大数据热之后,以深度学习为代表的人工智能成为当下最为热门的技术,越来越多的企业已经或者正在准备进军深度学习,特别是那些已经在大数据领域投入了重金,建立起了庞大的大数据集群的公司,由于有了大数据的这个基础,在深度学习之路上更为积极和主动。

不过,对于其中一些初涉人工智能技术的公司,要想从深度学习技术受益并不容易。此时,非常希望有一款简单好用的深度学习框架,基于此可以快速开发自己的深度学习应用,从而尽快从人工智能这项技术中受益。好在用户的这一希望并非空想,今天市场上已经有这类技术解决方案,英特尔去年开源的大数据深度学习框架BigDL就是其中之一,而且是其中的佼佼者。据悉,BigDL如今已经被用户广泛认可,在不少企业级应用中发挥重要作用。

简化Hadoop用户的AI之路

英特尔是芯片行业的龙头老大,这一点人所共知。而不少人不了解的是,英特尔还是大量软件研发人员开发出不少优秀的软件产品,其中除了一些为优化芯片性能的函数库之外(比如计算函数库 Math Kernel Library),也包括一些应用软件,比如大数据。BigDL是英特尔在大数据领域开发的众多软件中的一个。

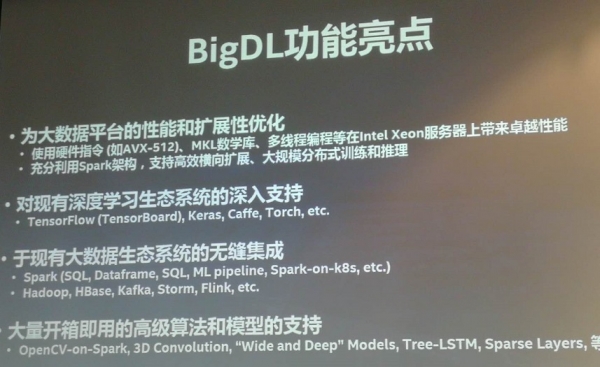

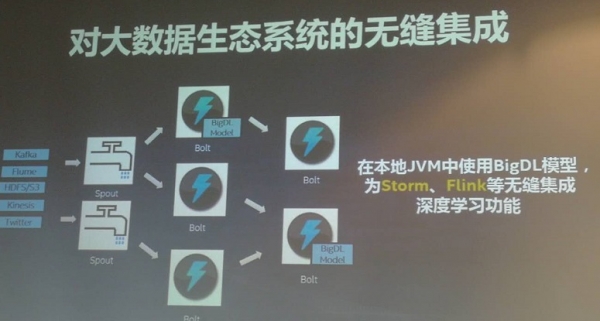

BigDL是一个基于Apache Spark的开源分布式深度学习框架,于2016年12月对外正式发布。“我们的目的是让深度学习和大数据平台能够无缝、非常容易地结合在一起,使得深度学习更易于被大数据的社区和数据科学的社区使用。”英特尔高级首席工程师、大数据技术全球CTO戴金权谈及研发这个软件的原因时表示。

戴金权告诉至顶网记者,这款产品主要面向使用Hadoop进行大数据的存储和分析处理的用户。它们在Hadoop上有过较大投入,拥有大量数据集存储在存储在Hadoop集群中。如果想利用数据进行深度学习的训练,通常需要把这些数据导出,然后进行处理。这个过程耗时而且投资不小,BigDL的目的就是让这些用户可以直接在Hadoop平台上进行深度学习的训练。

“在真正的生产环境当中,很多时候数据量是非常庞大的,要做非常多的数据清洗、数据处理工作。这些生产数据通常存储在大数据集群里,或者是分布式文件系统HDFS或者是分布式表存储Hbase,集群规模可能达几千台、几万台。如果再设立一个单独的集群专门做深度学习,首先要做的事情就相当于要把这些数据从几千台、几万台大数据集群拷贝到新的集群上,然后再进行分析。而且这还不是一个一次性的工作,因为数据在不停的变化中,需要对数据进行不同的处理和分析,这个数据拷贝的过程成为了非常大的瓶颈。

戴金权解释说,英特尔要做的就是让用户使用BigDL,这样就可以直接在现有的大数据集群上用深度学习技术来分析大数据,而不需要对数据进行任何拷贝。而之所以选择基于Apache Spark来开发BigDL,是因为Apache Spark是今天在大数据分析领域最领先、使用最广泛的大数据分析框架。“Apache Spark本身提供了一个非常高性能的分析引擎——一个基于内存的低延时、分布式数据分析的引擎,在上面用户可以进行各种各样的数据分析,很多Hadoop的应用都采用了Spark。” 戴金权说。

降低AI的学习成本

除了成本节省之外,BigDL的另一个特点是可以大大降低Hadoop用户的AI学习成本,比如,通过重用Hadoop平台上的现有大数据工具和流程,包括工作流的管理、资源管理等,这样可以大大提高用户深度学习应用的开发效率以及应用部署的效率。

“当深度学习被越来越多的人所接受后就希望它能够应用在生产中,而在构建新的人工智能深度学习应用时,那些普通大数据的用户尽管拥有大数据工程师或者数据科学家、数据分析师,但这些人很可能只会写SQL,并不擅长编程代码,也不是深度学习的专家,他们过去主要使用Hadoop、Spark平台来管理数据,对数据进行SQL处理、流分析,或者做一定的数据挖掘、机器学习、图分析等。”戴金权表示,这些人使用的一整套工具、架构和深度学习社区的工具、架构之间是有“断层”的,有了BigDL之后这些人就可以顺利填补这个“断层”。

戴金权说,英特尔希望借助BigDL来帮助用户,特别是大量的普通用户来跨越上述断层,能够让他们使用比较熟悉和了解、对他们来说也更加友好的一个软硬件架构,来让深度学习技术在他们现有的应用环境当中落地。

据悉,BigDL于2016年12月在GitHub上发布了第一个版本后,在接下来差不多一年多的时间发布了四个主版本。其中除英特尔外,BigDL也收到众多社区用户的代码贡献,比如阿里巴巴等等。而在用户方面,目前,BigDL四个版本都有用户在使用,遍布很多行业用户,也不乏知名用户。比如在国外有AWS、Azure、IBM、MasterCard,在国内有阿里巴巴、京东、金山云等。“

“我们很自信,我们认为BigDL是目前为止所看到的在大数据平台上开发深度学习应用的最好的框架和平台。” 戴金权说。

很显然,戴金权所说的这份自信并非盲目。

最后值得一提的是,英特尔其实在人工智能整个的技术栈上是做了非常多的工作,英特尔一直致力于提供端到端全栈人工智能解决方案,从设备端到网络到数据中心到云端,从底层硬件再到上层的优化计算库,比如英特尔的数学核心函数库MKL(Math Kernel Library),这是英特尔平台上最快的数学计算库,还有英特尔Nervana Graph计算库等,英特尔在上面也做了大量针对英特尔平台的优化工作,从TensorFlow到Caffe、Caffe2、AlexNet等,当然也包括基于Spark上的BigDL分布式深度学习的计算库等。

好文章,需要你的鼓励

Linux在CES 2026:企鹅系统依然活跃于物联网、汽车和AI领域

虽然在CES 2026展会上需要仔细寻找才能发现Linux的身影,但它确实无处不在。Canonical展示了与英伟达合作的Ubuntu Linux桌面超级计算机,配备GB10芯片、128GB内存和4TB存储。公司还演示了Ubuntu Core在IoT设备中的应用,以及为应对欧盟网络韧性法案推出的Ubuntu Pro设备支持方案。此外,Linux正成为软件定义汽车、边缘AI和智能电视的默认平台。

剑桥大学突破性研究:如何让AI在对话中学会真正的自信判断

剑桥大学研究团队首次系统探索AI在多轮对话中的信心判断问题。研究发现当前AI系统在评估自己答案可靠性方面存在严重缺陷,容易被对话长度而非信息质量误导。团队提出P(SUFFICIENT)等新方法,但整体问题仍待解决。该研究为AI在医疗、法律等关键领域的安全应用提供重要指导,强调了开发更可信AI系统的紧迫性。

Vibe Bot推出桌面AI智能体设备

智能白板制造商Vibe发布桌面AI设备Vibe Bot,集成语音助手、智能摄像头和AI笔记功能。该设备采用圆柱形设计,配备4K摄像头、波束成形麦克风和可旋转屏幕,能够跟踪发言者并自动调整视角。支持在线和离线会议录音,提供实时转录和AI生成的会议纪要,用户可通过语音助手查询会议信息并触发日历等应用操作。

威斯康星大学研究团队破解洪水监测难题:AI模型终于学会了“眼观六路“

威斯康星大学研究团队开发出Prithvi-CAFE洪水监测系统,通过"双视觉协作"机制解决了AI地理基础模型在洪水识别上的局限性。该系统巧妙融合全局理解和局部细节能力,在国际标准数据集上创造最佳成绩,参数效率提升93%,为全球洪水预警和防灾减灾提供了更准确可靠的技术方案。

Vibe Bot推出桌面AI智能体设备

Razer推出桌面AI动漫全息投影智能助手

Cloudera:构建符合伦理标准的AI,可信数据是关键

Nvidia发布Vera Rubin AI计算平台,性能大幅提升

7种削弱IT业务价值的致命做法

PTC在NRF 2026大会上发布AI驱动的FlexPLM新功能

如何终结针对IT部门的指责游戏

Windchill + Makersite,让可持续性从“理念”变为“行动”

Linux基金会领导者:我们并未处在AI泡沫中

全新软件与模型优化为 NVIDIA DGX Spark 注入强大动力

NVIDIA DGX Spark 为桌面端最新开源与前沿AI模型提供强大算力支持

AI流量激增为何现在就需要光网络自动化