AWS全面推出无服务器应用程序库

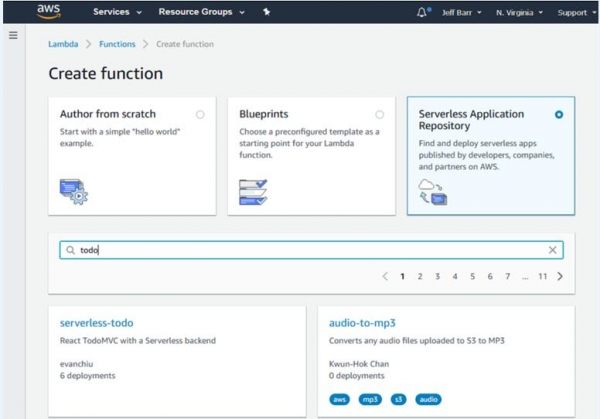

至顶网软件频道消息: AWS周三宣布全面推出AWS无服务器应用程序库(AWS Serverless Application Repository),让用户可以查找并部署无服务器应用程序及组件,据悉,之前的版本是公开预览版,可以从Lambda Console访问无服务器应用程序库(Serverless Application Repository)。

对于消费者而言,可以将无服务器应用程序和组件按照原样从存储库配置并部署到AWS账户,还可以添加功能并将提交请求提交给作者。

对于发布者,在提交文稿时要填写名称、说明、标签并选择一个开源许可证。然后,发布者提供现有源代码报告、SAM模板和指定语义版本的链接。

亚马逊表示,应用程序可以部署在美国东部(俄亥俄州)、美国东部(弗吉尼亚北部)、美国西部(北加州)、美国西部(俄勒冈州)、亚太地区(东京)、亚太地区(首尔)、亚太地区(孟买)、亚太地区(新加坡)、亚太地区(悉尼)、加拿大(中部)、欧盟(法兰克福)、欧盟(爱尔兰)、欧盟(伦敦)和南美洲(圣保罗)等地区。

要实现全球可用性,你可以从美国东部(弗吉尼亚北部)或美国东部(俄亥俄州)等地区进行发布。

好文章,需要你的鼓励

让AI记住房间每个角落:悉尼大学团队如何让视频生成拥有“空间记忆“

悉尼大学和微软研究院联合团队开发出名为Spatia的创新视频生成系统,通过维护3D点云"空间记忆"解决了AI视频生成中的长期一致性难题。该系统采用动静分离机制,将静态场景保存为持久记忆,同时生成动态内容,支持精确相机控制和交互式3D编辑,在多项基准测试中表现优异。

西班牙病毒如何将谷歌带到马拉加

33年后,贝尔纳多·金特罗决定寻找改变他人生的那个人——创造马拉加病毒的匿名程序员。这个相对无害的病毒激发了金特罗对网络安全的热情,促使他创立了VirusTotal公司,该公司于2012年被谷歌收购。这次收购将谷歌的欧洲网络安全中心带到了马拉加,使这座西班牙城市转变为科技中心。通过深入研究病毒代码和媒体寻人,金特罗最终发现病毒创造者是已故的安东尼奥·恩里克·阿斯托尔加。

马里兰大学突破性发现:AI推理过程终于有了“身体检查“——ThinkARM框架揭开大型语言模型思维奥秘

马里兰大学研究团队开发ThinkARM框架,首次系统分析AI推理过程。通过将思维分解为八种模式,发现AI存在三阶段推理节律,推理型与传统AI思维模式差异显著。研究揭示探索模式与正确性关联,不同效率优化方法对思维结构影响各异。这为AI系统诊断、改进提供新工具。

生命科学计算测试专委会正式成立,BioProfile框架引领行业标准建设

超智算完成北京核心智算中心资产收购,加速构筑“3+X”全国算力网络新格局

走出“参数崇拜”:联想用“一体多端”重塑“人的尺度”

从“单点突破”到“一体多端”:拆解天禧AI 3.5进化背后三年的进化哲学

openGauss Summit 2025在京召开,加速行业智能化变革,共建繁荣数据库生态

2025联想天禧AI生态伙伴大会:天禧AI一体多端,与开发者共建个人AI生态

西班牙病毒如何将谷歌带到马拉加

LangChain核心库曝出严重漏洞,AI智能体机密信息面临泄露风险

Mill如何与亚马逊和全食超市达成合作协议

TechCrunch创业大赛中的9家顶尖生物技术初创公司

2025年印度科技领域十大重要发展

中科大发布Live Avatar:AI数字人无限聊天不翻车

AWS亮相CES公布将AI引入汽车领域的合作成果

AI冲上App Store热门,开发者争相搭上流量快车

Nvidia和AWS联手加速云端AI部署

在re:Invent大会上,AWS聚焦企业人工智能,在Bedrock方面取得了进展,并推出了新模型

红帽扩展 AWS 联盟,提供更多 Ansible 和 OpenShift 产品

IBM宣布将最强大的Granite AI模型引入AWS云端

AWS Lambda的十年历程:无服务器愿景塑造云和AI的未来

AMD EPYC 9005服务器BIOS & 工作负载调优指南

AWS App Studio全面上市,让人人都能构建应用程序

AWS加入避风港联盟,增强金融部门网络韧性