谷歌凭借强大的新型芯片 迎接量子计算时代

整个科技行业都在积极推动能够全面超越现有硬件能力的大型量子计算机,而这方面工作也确实取得了突飞猛进的发展。

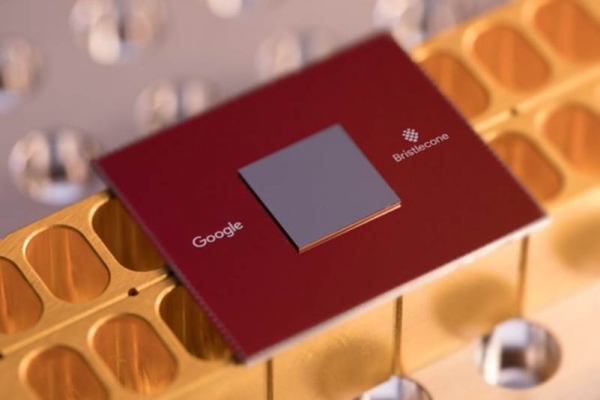

最新的发展成果来自谷歌公司,其于本周一推出了首款72量子位(见上图)量子处理器,这也是迄今为止出现的计算能力最强的量子处理器。而亚军头衔则由IBM公司于去年制造的50量子位芯片所持有。

量子位就相当于量子版本的bit位,其突出特性在于能够代表三个可能的数据值,而非传统思维中的1与0两个。这种看似微小的差异在大型量子计算机带来颠覆性的容量提升。事实上,技术行业相信,即使是目前最强大的超级计算机都解决不了的难题,也同样难不倒这类量子计算机。

科学家们将这一理论性能优势称为“量子优势”,谷歌公司则希望在新芯片中真正将其变为现实。这款处理器被称为Bristlecone,旨在为该公司的研究人员提供一套测试平台,从而探索如何实现量子计算的全部潜力。

将更多量子位集成至芯片之上还仅仅只是需要解决的实际需求之一。另一方面,则在于确保该系统能够以充分的可靠性处理数据以保持高水准的准确性——考虑到量子位的易变性,这绝对不是件轻松的任务。大多数量子处理器对于外界干扰因素非常敏感,因此必须被保持在接近绝对零度的工作环境之下。

为了实现可靠性,谷歌公司在设计Bristlecone时充分借鉴了其早期开发的9量子位系统,其错误率可低至0.6%。此外,谷歌方面还开发出专门设计的基准测试工具,用以衡量这款样报处理器的准确度。利用这款工具,研究人员们将能够在传统硬件上模拟量子计算机,从而检查计算结果。

在一篇博文当中,谷歌公司科学家Julian Kelly写道,其目标在于让Bristlecone与此前的9量子位处理器拥有类似的准确度。他同时透露称,谷歌公司对此抱有“谨慎的乐观态度”,并认为进一步实现量子优势确实具备可行性。

这代表着一次历史性的突破,同时也标志着技术行业已经朝着打造原本仅存在于科幻小说中的那种超大功率量子计算机的目标迈出了一大步。此类设备将使得科学家们能够在当前硬件所无法实现的计算能力高度之上进行研究。然而,其也可能带来平板的风险。根据估计,一台4000量子位的计算机将有可能破解RSA-2048——即目前最为尖端的数据保护加密技术。

好文章,需要你的鼓励

M-A-P团队首次实现:从一首歌自动生成完整MV!音乐视频制作迎来AI革命

M-A-P团队开发的AutoMV系统首次实现从单首歌曲自动生成完整音乐视频,采用多智能体协作模式,包含音乐分析、智能编剧、视觉导演和质量审核等模块。在30首测试歌曲上,AutoMV在音乐内容相关性和技术质量方面显著超越商业竞品,制作成本仅10-20美元,耗时30分钟,大幅降低了MV制作门槛,为音乐创意产业带来革命性变化。

至顶AI实验室硬核评测:HP Z2 Mini G1a工作站,仅30分钟还原毛利侦探事务所

真相只有一个:在AI与创意的交汇点上,HP Z2 Mini G1a确实是一台值得推荐的灵感引擎。

UCLA携手Salesforce新突破:智能手机也能拥有“预知未来“的能力

UCLA联合Salesforce开发出革命性"语义世界模型",让AI助手首次具备预知手机操作结果的能力。研究团队创建了包含140万样本的MobileWorld数据集和MobileWorldBench评估系统,通过让AI用自然语言描述状态变化而非预测像素细节,实现了7.4%的任务成功率提升,为智能助手技术开辟了全新发展路径。

EcoStruxure(TM) Building GPT楼宇智能运维专家

拥抱AI,HPE Networking以“自动驾驶的网络”引领智能网络新时代

至顶AI实验室硬核评测:HP Z2 Mini G1a工作站,仅30分钟还原毛利侦探事务所

冷板式液冷CDU系统

我们希望AI有多智能?世界模型可能比我们更懂世界

首席信息官角色将在2026年扩展的四种方式

Waymo正在测试Gemini在无人驾驶出租车中的车载AI助手功能

数据中心从幕后走向台前的转折之年

意大利要求Meta暂停禁止竞争对手AI聊天机器人使用WhatsApp的政策

让老旧Windows和macOS系统延续生命力

微软计划到2030年用Rust语言替换所有C和C++代码

2026年创客工具迎来重大升级,这些新技术值得期待