企业数据是如何“养成”的? 原创

如今,数据仍在以爆发的态势不断增长,并且充当着企业数字化转型的核心驱动力,成为商业模式创新的重要基础。然而,据统计,目前只有20%的数据得到了挖掘和利用,还有剩余80%的绝大多数数据由于不能被访问、不能被信任、或是不能被分析,价值无法释放,也无法被充分应用。

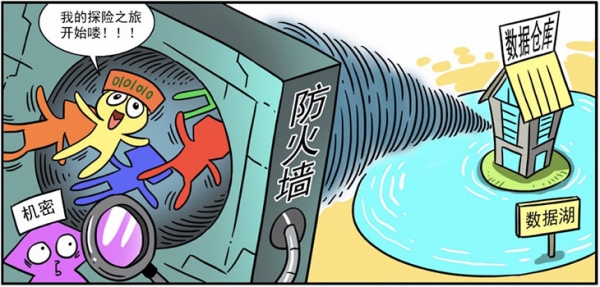

为了挖掘数据的价值,企业首先要对数据进行收集。一般而言,企业往往需要将来自不同系统的数据复制或迁移到中央数据存储器(如数据仓库和数据湖)进行管理和分析,最终为业务赋能。出于历史记录、归档或监管等目的,这是企业必须采取的一种手段。

另一方面,对于一些安全级别较高的数据,作为现有方法的补充,企业还可以通过数据虚拟化,跨多个系统从源头对数据进行分析查询。这不仅可以降低成本,避免移动和复制造成的延迟,还可以简化分析步骤并保证其准确性。

但是,并不是每一个数据对于企业而言都具备价值,在对数据进行分析之前,所有数据都必须经过统一组织和管理,包括数据的清洗、集成、编目和治理,从而确认和优化数据价值。比如,对结构化和非结构化数据进行转换和整理,对不合规、不值得信赖的数据进行处理等等。在这个过程中,企业需要一个统一的治理与集成平台了解数据是否正确、是否可用,同时保证数据的安全性。

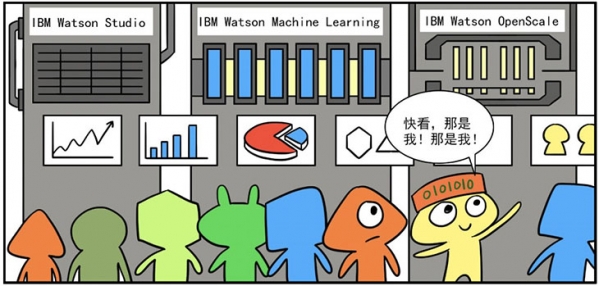

现下,数据分析工具正在不断升级。借助AI工具和平台,不仅能够随时随地访问数据,同时还可以对数据集进行训练并构建模型,进行数据挖掘和统计分析。除此之外,根据对AI分析结果的跟踪,还可以随着不断变化的业务情况调整和管理AI,最终实现预测性分析和规范性分析,为企业业务赋能做好充分准备。

当然,数据源于业务,最终还要回归于业务。可信的数据分析结果,经过与不同系统数据之间的整合,以及与具体业务场景的融合,将为企业提高运营效率、节约成本支出、实现业务洞察、提高客户体验、创新商业模式提供智能和自动化的方法,并为企业决策提供参考和建议。

可以看到,从离散到聚合,从离线到在线,从静止到流动,被AI加持的数据,其价值也将被充分释放。

好文章,需要你的鼓励

CIO对2026年AI发展的五大预测

2025年,企业技术高管面临巨大压力,需要帮助企业从持续的AI投入中获得回报。大多数高管取得了进展,完善了项目优先级排序方法。然而,CIO仍面临AI相关问题。支离破裂的AI监管环境和宏观经济阻力将继续推动技术高管保持谨慎态度。随着AI采用增长的影响不断显现,一些CIO预期明年将带来劳动力策略变化。

Anthropic最新CJE技术:让AI评判AI不再瞎猜,终结LLM评估乱象

这篇论文提出了CJE(因果法官评估)框架,解决了当前LLM评估中的三大致命问题:AI法官偏好倒置、置信区间失效和离线策略评估失败。通过AutoCal-R校准、SIMCal-W权重稳定和OUA不确定性推理,CJE仅用5%的专家标签就达到了99%的排名准确率,成本降低14倍,为AI评估提供了科学可靠的解决方案。

云成本管理变得更加便捷

FinOps基金会周四更新了其FinOps开放成本和使用规范云成本管理工具,新版本1.3更好地支持多供应商工作流。该版本新增了合同承诺和协商协议数据集,增加了跨工作负载成本分摊跟踪列,以及云支出和使用报告时效性和完整性的元数据可见性。随着云和AI采用推动企业IT预算增长,技术供应商正在关注将成本与价值联系起来的努力。大型企业通常使用三到四家云供应商,小企业可能使用两家,同时还有数据中心、SaaS和许可等服务。

NVIDIA团队让立体视觉AI实现“真正“实时运行:速度提升10倍却不牺牲精度

NVIDIA团队开发出Fast-FoundationStereo系统,成功解决了立体视觉AI在速度与精度之间的两难选择。通过分而治之的策略,该系统实现了超过10倍的速度提升同时保持高精度,包括知识蒸馏压缩特征提取、神经架构搜索优化成本过滤,以及结构化剪枝精简视差细化。此外,研究团队还构建了包含140万对真实图像的自动伪标注数据集,为立体视觉的实时应用开辟了新道路。

最热门的 AI 模型:它们的功能和使用方法

这款古怪的 AI 智能手机可以创建你的数字分身

Faireez 获 750 万美元融资,为租赁市场提供 AI 驱动的酒店式管家服务

Broadcom 大获全胜:70% 大型 VMware 客户购买其最全面解决方案

Peer 获得1050万美元元宇宙引擎投资,推出3D个人星球功能

获 3000 万美元融资,Crogl 发布面向安全分析师的全新 AI "钢铁侠战衣"

Turing 获得 1.11 亿美元融资,估值达到 22 亿美元,为 OpenAI 等大语言模型公司提供关键代码支持

Tavus 推出系列 AI 模型,实现实时人脸交互技术突破

Welevel 获得 570 万美元融资,革新程序化游戏开发

AI 驱动的卓越运营:企业如何通过人人可及的流程智能提升成功