疫情之下的AI,让视觉障碍人士在隔离期间继续学习

至顶网软件与服务频道消息:攀岩运动员Abbie Robinson,尽管顶着光芒四射的世界冠军头衔,但视觉障碍一直困扰着她。

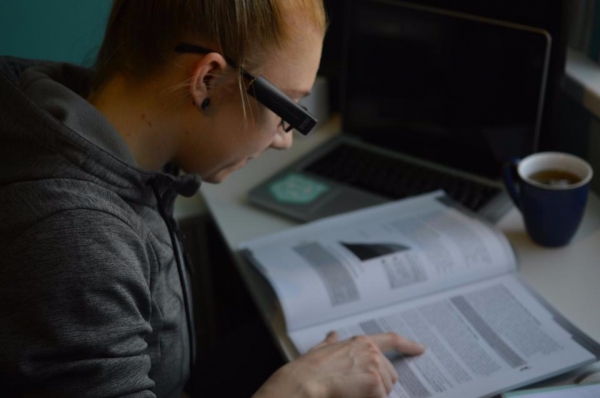

▲ 图:19岁的攀岩世界冠军Abbie Robinson,在COVID-19期间,使用AI设备继续完成学业。

17岁那年,Robinson被诊断出患有斯塔加特黄斑变性,这是一种少年性黄斑变性疾病,会导致病人逐渐丧失视野中心区的视力。换句话说,她将越来越难以细致感知色彩,也让阅读与观察等日常行动变得格外困难。

但这并没有阻止她拿下攀岩世界冠军,保持个人独立性,并继续在利兹大学攻读专业。

但与其他大部分学生一样,随着英国在COVID-19疫情下全面隔离,Robinson也不得不待在家中学习。为了完成学业,她正依靠一种使用机器学习与计算机视觉技术的设备,帮助自己完成疫情隔离期间的日常活动。

该设备来自于OrCam公司推出的MyEye2设备。这款设备配备有人工智能(AI),能够直接安装在普通眼镜架上,并直接用语音读出印刷文本或者数字文本中的内容。

她表示:“我的主要需求就是阅读。现在,我终于能够顺畅地读完一本普通书了。有了这种正常阅读的能力,我也可以阅读很多额外的材料与论著。”

由于无法在课堂上直接讨论和辅导,大学讲师们只能为学生们准备了更多阅读材料,这也使年轻人们近来的阅读需求显著提升。MyEye2设备同时支持人脸识别功能,Robinson可以在一定范围内快速辨认出自己的好友。

另外,她也用MyEye2设备读取演讲中的展示信息、培训时间表、训练计划以及食品标签等等——对芝麻过敏的她,尤其关注这最后一点。

当然,MyEye 2唯一做得不够的,就是在攀岩过程中为她提供帮助。 “但我也非常理解,毕竟MyEye 2并不是为此而设计。它给我带来巨大帮助,支持我正常完成日常生活。”

她还提到,“在使用MyEye2之前,完成生活中任何一件琐事,都需要双倍的时间,导致我真的很难保持一周20个小时的攀岩训练。我的生活可以说是连轴转,毫无喘息之机。”

另外,她也说起MyEye2的另一项重要功能——除了阅读训练教程,它还帮助这位年轻的冠军独自出行。现在,无需他人的指引,她就能直接读取指示牌上的信息。

至于OrCam MyEye2设备的工作原理,其使用计算机视觉来处理识别到的每一幅图像中的数百万个数据点,并从中筛选出对用户最有用的信息。这台设备能够检测出用户的手指激活操作,大声读出文本,同时用语音向设备佩戴者提示人脸、产品、纸币面额以及颜色等信息。

虽然这款产品背后的底层技术OCR(即光学字符识别)已经存在多年,但OrCam方面正努力将这项成果引入更多设备,帮助用户解答与文本内容相关的种种问题。例如,用户可以手持电费单,并要求设备读出其中的付款截止日期。

好文章,需要你的鼓励

为何MCP服务器已成为关键微服务架构组件

模型上下文协议(MCP)服务器是连接概率性大语言模型和确定性微服务工作流的关键节点,充当推理引擎与外部数据工具的翻译层。在生产环境中部署AI智能体时,MCP服务器承担着定义智能体能力、管理上下文数据和执行操作三大核心职责。由于其非确定性客户端特性,传统单元测试无法有效验证,需要通过端到端测试来确保系统可靠性,这使得MCP服务器成为智能体架构中不可或缺的关键基础设施。

UCSD团队打造终极仿真世界:让AI智能体在虚拟城市中自立更生的惊人实验

SimWorld是由UCSD等多所顶尖院校联合开发的革命性AI仿真平台,基于虚幻引擎5构建了具备真实物理规律的虚拟城市环境。该平台支持无限扩展的程序化世界生成和自然语言交互,让AI智能体能够在复杂环境中学会生存、合作和竞争,为通用人工智能的发展提供了前所未有的训练平台。

英伟达发布Vera Rubin架构,专为AI智能体设计

英伟达推出Vera Rubin计算平台,专为驱动具备思考和推理能力的智能AI系统而设计。该平台采用NVL72液冷机架系统,集成六种芯片包括新Vera CPU和Rubin GPU。相比Blackwell架构,Rubin GPU推理速度提升5倍,训练速度提升3.5倍。平台还推出推理上下文内存存储解决方案,性能提升5倍。此外,英伟达还发布了面向自动驾驶的开源Alpamayo模型系列。

浙江大学团队提出C2DLM:让AI推理更像人类思维的全新语言模型

浙江大学联合华为提出C2DLM,这是一种因果概念引导的扩散语言模型,通过自动提取因果关系并融入注意力机制来增强AI推理能力。相比传统方法,C2DLM在推理任务上平均提升1.31%-12%,训练效率提高3.2倍,为解决语言模型推理能力不足开辟了新路径。

全新软件与模型优化为 NVIDIA DGX Spark 注入强大动力

NVIDIA DGX Spark 为桌面端最新开源与前沿AI模型提供强大算力支持

AI流量激增为何现在就需要光网络自动化

AMD 推出锐龙 AI 嵌入式处理器产品组合,为汽车、工业和物理 AI 领域提供 AI 驱动的沉浸式体验

Kubernetes推出AI一致性认证计划,VMware率先通过认证

为何MCP服务器已成为关键微服务架构组件

英伟达发布Vera Rubin架构,专为AI智能体设计

富士通前支持团队被称为"合法黑客"

AI承诺减少繁重工作却可能增加复杂性和压力

TCL推出首款HDR智能显示眼镜,画面效果令人印象深刻

亚马逊首款彩色电子阅读器Kindle Colorsoft降价50美元

惠普OmniBook笔记本全新设计搭载OLED显示屏