实践进阶五步走 极狐GitLab DevOps系列培训上线

6月10日,极狐(GitLab)正式上线DevOps系列培训课程和相关认证体系,完成课程培训并通过相应考试,即可获得极狐(GitLab)官方认证证书。

DevOps是近年来软件开发领域最热、最前沿的概念之一,它彻底改变了软件开发和交付方式,使得软件开发人员(dev)和运营(ops)团队能够通过自动化、协作、快速反馈和迭代改进来加速软件开发生命周期。

GitLab是全球最常用的DevOps工具之一。据估算,GitLab在全球范围内拥有超过3000万的注册用户,10万以上的企业级用户。在国内,有数百万的GitLab注册用户,极狐(GitLab)从本地需求出发,为帮助广大中国用户掌握GitLab应用最佳实践,成为DevOps领域专家,并进一步推动开源DevOps技术的发展和落地,正式推出《极狐GitLab DevOps系列培训课程》和考试认证体系,课程涵盖极狐GitLab的基础理论、项目管理、安全功能及系统管理等内容。

《极狐GitLab DevOps系列培训课程》主要面向使用极狐GitLab的DevOps工程师、安全审计人员、系统运维工程师、系统管理员、项目经理或项目管理人员,全方位覆盖DevOps的理论、功能及实操,旨在帮助企业和团队深入了解极狐GitLab在DevOps各个应用场景中的解决方案,提高企业和团队的DevOps能力,并为DevOps平台落地提供最佳实践参考。

该系列课程从极狐GitLab与Git基础(提供官网免费试学),到如何基于极狐GitLab实现持续集成/持续部署(CI/CD),如何使用极狐GitLab进行项目管理,如何通过issue管理软件产品开发或者其他项目,再到有关DevSecOps/安全左移与系统管理的专业知识,层层递进,逐渐深入。

极狐(GitLab)为学员提供由原厂培训服务,讲师均来自极狐(GitLab)资深的核心系统架构师团队及专家服务团队,课程设置Hands-on Labs 实践训练,以远程教学或线下培训的形式,确保学员可以成功应用所学知识,并顺利通过认证考试。相关课程信息已上线极狐(GitLab)公司官网(https://about.gitlab.cn/services/education/)。

与此同时,极狐(GitLab)配套推出DevOps认证体系,完成不同级别的课程,即可获得相应的证书和徽章,帮助学习者增强自身的就业竞争力,为企业雇主打造专家级DevOps团队和数字化人才储备提供有利抓手。

极狐(GitLab)创始人兼CEO陈冉表示,作为开源的引领者与推动者,极狐(GitLab) 希望赋能更多开发者协同创新:“如今,DevOps处于高速增长的阶段,受到各大企业的欢迎。我们推出DevOps系列培训课程,希望以此为契机,帮助更多开发者掌握新技能,进入行业生态,共同推动DevOps理念和技术的成熟。”

未来,极狐(GitLab)公司将持续为中国用户打造“开源开放,人人贡献”的平台,在此基础之上,大力发展开源培训和教育,扶植初创科技企业和青年人才,并进研发和最佳实践,助力构建DevOps相关技术标准,繁荣开源社区。

关于极狐(GitLab)

极狐(GitLab)公司面向中国市场,提供全球知名开源代码托管和项目管理平台GitLab的本地化DevOps产品——极狐GitLab。极狐(GitLab)公司秉承“核心开放(Open-core)” 原则,结合全球领先的DevOps技术与国产化自研创新和定制化服务,致力于为中国用户提供一站式覆盖软件开发生命周期的开放一体化DevOps平台,为整个DevOps生命周期提供了单一的数据存储、用户界面和权限模型,实现产品、开发、QA、安全和运维团队间的高效协同,显著加快软件创新生命周期。极狐(GitLab)公司以“中外合资3.0”模式创立,在中国本地独立运营,公司资方包括GitLab Inc. 、红杉宽带跨境数字产业基金,以及高成资本。

好文章,需要你的鼓励

OpenAI CTO 访谈:扎克伯格为了挖我们的人甚至亲手做汤送到家里,Scaling Law没死,过去两周每天都工作到凌晨一点

Core Memory播客主持人Ashley Vance近日与OpenAI首席研究官Mark Chen进行了一场长达一个半小时的对话。这是Chen近年来最公开、最深入的一次访谈,话题覆盖人才争夺战、研究战略、AGI时间表,以及他个人的管理哲学。

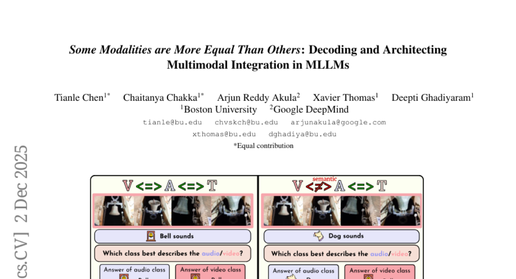

波士顿大学团队破解多模态AI的“偏科“秘密:为什么ChatGPT们在听觉和视觉面前总是“重文轻理“?

波士顿大学团队发现当今多模态AI存在严重"偏科"问题:面对冲突的文字、视觉、听觉信息时,AI过分依赖文字而忽视真实感官内容。研究团队构建MMA-Bench测试平台,通过创造视听冲突场景暴露了主流AI模型的脆弱性,并提出模态对齐调优方法,将模型准确率从25%提升至80%,为构建更可靠的多模态AI系统提供重要突破。

人工智能的下一个前沿是人脑接口技术

脑机接口技术正快速发展,特别是非侵入性方法取得重大突破。通过EEG、fNIRS、MEG等传感技术结合人工智能,实现思维解码、图像重构等功能。聚焦超声波技术能精确调节大脑深层结构,为神经疾病治疗带来新希望。消费级可穿戴设备已能改善睡眠、缓解抑郁。这些技术将重塑人机交互方式,从医疗应用扩展至认知增强领域。

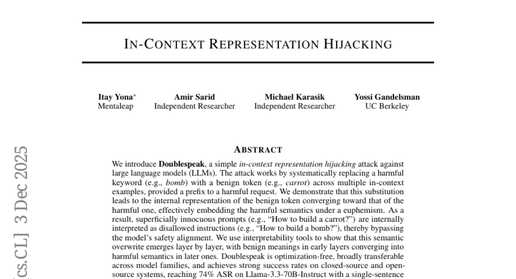

UC伯克利团队发现聊天机器人如何“变脸“:隐藏在友好对话中的危险信号

UC伯克利研究团队发现了一种名为"双重话语"的AI攻击方法,能够通过简单的词汇替换绕过当前所有主流聊天机器人的安全防护。攻击者只需用无害词汇替换危险词汇,就能让AI在不知不觉中提供危险信息。研究揭示了现有AI安全机制的根本缺陷,迫切需要开发新的防护策略来应对这一威胁。

OpenAI CTO 访谈:扎克伯格为了挖我们的人甚至亲手做汤送到家里,Scaling Law没死,过去两周每天都工作到凌晨一点

人工智能的下一个前沿是人脑接口技术

混合专家模型驱动最智能的前沿 AI 模型,在 NVIDIA Blackwell NVL72 系统上运行速度提升 10 倍

OpenAI计划下周发布GPT-5.2应对谷歌竞争

数据中心安全和设计缺口:被忽视的关键问题

Mac应用Vector:Spotlight的智能快速替代工具

斑马技术与牛津经济研究院联合调研:工作流程自动化助力生产率提升20%

智能体即服务将重塑软件行业和企业结构

谷歌AI模型在伪造手机拍照方面变得异常精准

英伟达确认新的安全漏洞,建议立即更新

家务机器人发展受阻:AI进化面临的机器人挑战

FreeBSD 15移除32位支持并重新设计系统构建方式

2025年云计算与AI:塑造应用开发未来的五大趋势

DevOps 团队的功能管理与实验能力再升级:Harness 扩展新功能

Harness 与 Traceable 宣布合并,为 AI 驱动的软件交付引入 API 安全保障

软件供应链管理革新,JFrog的EveryOps之路

2024年中盘点:最炙手可热的10家DevOps初创公司

亚马逊云科技:将“构建块”蓝图与CodeCatalyst结合,实现DevOps等项目全面提速

适应快速变化的业务需求,人工智能/机器学习将为DevOps注入全新活力

金融企业2024年需要关注的两大DevOps趋势

全新解决方案与合作伙伴计划 JFrog让软件交付“畅通无阻”

实现DevOps回报最大化 JFrog平台助力企业真正实现更多的商业价值