Marvell与AWS达成合作,推动芯片EDA全面上云

Marvell公司日前宣布,计划将电子设计自动化(EDA)工作流程由本地迁移至亚马逊云科技(AWS)。Marvell同时强调,他们是AWS的“电光材料、网络、安全、存储及定制设计等解决方案”供应商。这项新消息相信对两家公司都有积极的推进意义。

EDA是工程师日常使用的IP块、芯片与SoC设计/模拟/调试/验证软件工具,主要由Cadence和Synopsis提供。过去十年以来,这类工具已经整合了AI技术,能够自动处理特定程序以改善产品上市时间。Cadence最近还推出了其Verisium平台,据称能够将调试生产率提升10倍。

凭借愈发强大的EDA工具,工程师们能够利用种种资源加快工作流程。但从另一个角度看,这也意味着EDA本身需要大量计算和存储资源作为支持。要想快速获取提示和答案,丰富的算力和内存必不可少。相较于本地设施,以AWS为代表的公有云显然特别适合这类工作负载。

Marvell公司产品和技术总裁Raghib Hussain也对公有云赞许有加,表示“将EDA工作负载迁往云端,将改变半导体的整个开发方式。通过在AWS云服务中运行EDA,Marvell将得以优化我们的芯片开发项目,加快我们的产品上市时间。”

Marvell并未具体说明其使用的AWS EC2实例、存储、内存、工具或文件系统,但我们可以在AWS网站上找到关于Marvell的信息(https://aws.amazon.com/solutions/semiconductor-electronics/electronic-design-automation/?solutions-all.sort-by=item.additionalFields.sortDate&solutions-all.sort-order=desc&marketplace-ppa-and-quickstart.sort-by=item.additionalFields.sortDate&marketplace-ppa-and-quickstart.sort-order=desc&solutions-whitepapers.sort-by=item.additionalFields.sortDate&solutions-whitepapers.sort-order=desc)。

Marvell还公开透露,他们本身也是AWS的重要半导体供应商。这也很正常,毕竟Marvell在云存储、电学材料、DPU(数据处理单元)、网络和HSM(硬件安全模块)等领域均处于市场领先地位。

Marvell的“灵活研发模型”

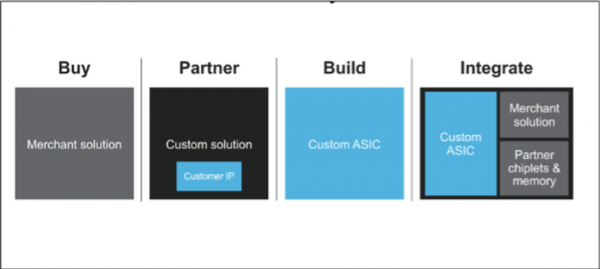

Marvell公司拥有先进的技术、IP、封装与互连储备。在芯片制造端,Marvell已经能够匹配台积电的最新3纳米顶级制程,掌握多种加速器,具备高速混合信号专家,也是多芯片模块(MCM)、共封装光学元件和封装内内存设计的领导者。Marvell的最终产品对应灵活的交付方式,客户可以直接购买、以伙伴身份参与合作(自定义IP)、通过自定义ASIC构建,或者与复杂的SoC集成。这些能力贯穿超大规模数据中心的计算、安全和存储等层面,并通过交换机连接各机架、通过光纤互连对接各处数据中心。尽管AWS没有阐明,但我个人相信Marvell应该是使用了AWS的Nitro SSD。身为云服务领域的绝对领导者,AWS也有必要积极采用Marvell的硬件安全模块。

AWS Amazon EC2副总裁David Brown在评论Marvell芯片能力的新闻稿中提到,“我们的客户通过与Marvell的合作而受益,他们将芯片创新推向了广泛而深入的云服务体系。”David Brown亲自发言,无疑是对Marvell的支持和肯定。

那么,两家运营良好的公司突然“互诉衷肠”,到底是想干什么?

虽然AWS拥有多种原研芯片(包括Nitro System、Graviton Compute、Inferentia Inference,以及即将推出的机器学习训练专用Trainium),但这类重大课题显然不是单一厂商就能解决的,所以也需要商业芯片供应商的扶持。Marvell的意义正在于此。我很期待AWS是否以及如何使用Marvell提出的所谓“灵活研发模型”中的自定义功能。对于AWS,这代表其云EDA服务已经取得重大胜利——40年来,第一次将这类负载从本地设施推上云端。同时,Marvell方面也能借此为客户提供更多新功能,为迎接半导体产业的未来做好准备。

好文章,需要你的鼓励

CIO对2026年AI发展的五大预测

2025年,企业技术高管面临巨大压力,需要帮助企业从持续的AI投入中获得回报。大多数高管取得了进展,完善了项目优先级排序方法。然而,CIO仍面临AI相关问题。支离破裂的AI监管环境和宏观经济阻力将继续推动技术高管保持谨慎态度。随着AI采用增长的影响不断显现,一些CIO预期明年将带来劳动力策略变化。

Anthropic最新CJE技术:让AI评判AI不再瞎猜,终结LLM评估乱象

这篇论文提出了CJE(因果法官评估)框架,解决了当前LLM评估中的三大致命问题:AI法官偏好倒置、置信区间失效和离线策略评估失败。通过AutoCal-R校准、SIMCal-W权重稳定和OUA不确定性推理,CJE仅用5%的专家标签就达到了99%的排名准确率,成本降低14倍,为AI评估提供了科学可靠的解决方案。

云成本管理变得更加便捷

FinOps基金会周四更新了其FinOps开放成本和使用规范云成本管理工具,新版本1.3更好地支持多供应商工作流。该版本新增了合同承诺和协商协议数据集,增加了跨工作负载成本分摊跟踪列,以及云支出和使用报告时效性和完整性的元数据可见性。随着云和AI采用推动企业IT预算增长,技术供应商正在关注将成本与价值联系起来的努力。大型企业通常使用三到四家云供应商,小企业可能使用两家,同时还有数据中心、SaaS和许可等服务。

NVIDIA团队让立体视觉AI实现“真正“实时运行:速度提升10倍却不牺牲精度

NVIDIA团队开发出Fast-FoundationStereo系统,成功解决了立体视觉AI在速度与精度之间的两难选择。通过分而治之的策略,该系统实现了超过10倍的速度提升同时保持高精度,包括知识蒸馏压缩特征提取、神经架构搜索优化成本过滤,以及结构化剪枝精简视差细化。此外,研究团队还构建了包含140万对真实图像的自动伪标注数据集,为立体视觉的实时应用开辟了新道路。