微软首次推出27亿参数的Phi-2模型,性能超过许多大型语言模型

微软发布了一款名为Phi-2的人工智能模型,该模型表现出了不凡的能力,其性能可媲美甚至超越规模是其25倍的、更大、更成熟的模型。

微软在近日的一篇博文中宣布,Phi-2是一个拥有27亿参数的语言模型,与其他基础模型相比,它在复杂的基准测试中表现出了 "先进的性能",这些测试评估了推理、语言理解、数学、编码和常识能力。Phi-2现在通过微软Azure人工智能工作室的模型目录发布,这意味着研究人员和开发人员现在就可以将其集成到第三方应用程序中。

Phi-2由微软首席执行官Satya Nadella(如图)于11月在Ignite大会上首次发布,其强大的功能得益于该公司所称的“教科书质量”数据(专门针对知识),以及学习其他模型传递的洞见的技术。

Phi-2 的有趣之处在于,传统上,大型语言模型的能力总是与其总体规模密切相关,而总体规模是以参数来衡量的。参数越大的模型通常能力越强,但 Phi-2 的出现改变了这种状况。

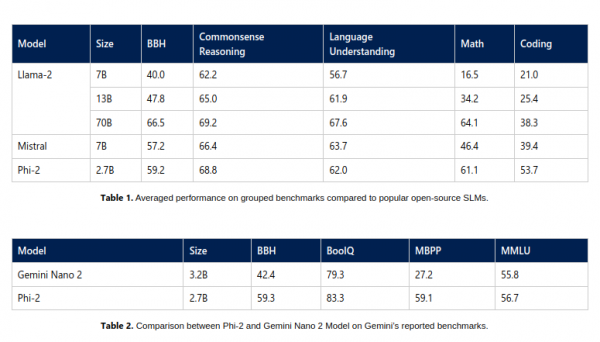

微软表示,Phi-2在某些基准测试中显示出与更大型的基础模型相匹敌甚至超越它们的能力,包括Mistral AI 70亿参数的Mistral、Meta Platforms公司130亿参数的Llama 2,甚至在某些基准测试中超过了700亿参数的Llama-2。

最令人惊讶的说法可能是,它的性能甚至超过了谷歌的 Gemini Nano,后者是上周发布的 Gemini系列LLM中效率最高的一款。Gemini Nano 专为设备上的任务而设计,可以在智能手机上运行,实现文本摘要、高级校对、语法修正以及上下文智能回复等功能。

微软的研究人员说,Phi-2涉及的测试非常广泛,包括语言理解、推理、数学、编码挑战等。

该公司表示,Phi-2之所以能取得如此优异的成绩,是因为它是用精心挑选的教科书级数据训练而成,这些数据旨在教授推理、知识和常识,这意味着它可以从更少的信息中学到更多的东西。微软的研究人员还使用了一些技术,允许从更小的模型中获取知识。

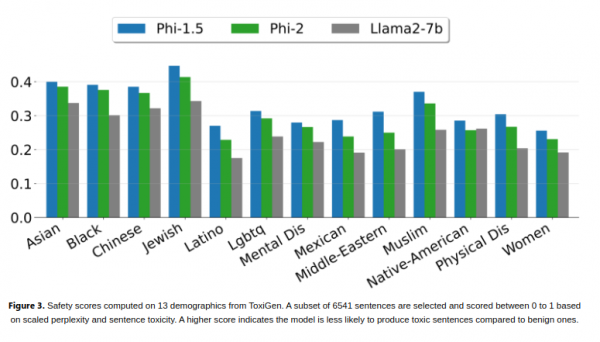

研究人员表示,值得注意的是,Phi-2可以不使用基于人类反馈的强化学习或者教学性微调等技术就实现强劲的性能,这些技术通常用于改善人工智能模型行为。尽管没有使用这些技术,但是与其他使用了这些技术的开源模型相比,Phi-2在减少偏见和有毒内容方面依然表现卓越。该公司认为这是量身定制的数据整理的功劳。

Phi-2是微软研究人员所称的“小型语言模型(SLM)”系列的最新版本。该系列第一个模型是 Phi-1,于今年早些时候首次发布,拥有13亿参数,针对基本的Python编码任务进行了微调。今年9月,该公司又推出了拥有13亿参数的Phi-1.5,使用新的数据源进行训练,其中包括用自然语言编程生成的各种合成文本。

微软表示,Phi-2的高效性使其成为研究人员探索增强人工智能安全性、可解释性和语言模型道德发展等领域的理想平台。

好文章,需要你的鼓励

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

很多人担心被AI取代,陷入无意义感。按照杨元庆的思路,其实无论是模型的打造者,还是模型的使用者,都不该把AI放在人的对立面。

MIT递归语言模型:突破AI上下文限制的新方法

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

谷歌宣布对Gmail进行重大升级,全面集成Gemini AI功能,将其转变为"个人主动式收件箱助手"。新功能包括AI收件箱视图,可按优先级自动分组邮件;"帮我快速了解"功能提供邮件活动摘要;扩展"帮我写邮件"工具至所有用户;支持复杂问题查询如"我的航班何时降落"。部分功能免费提供,高级功能需付费订阅。谷歌强调用户数据安全,邮件内容不会用于训练公共AI模型。

华为研究团队突破代码修复瓶颈,8B模型击败32B巨型对手!

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。

联想集团混合式AI实践获权威肯定,CES期间获评“全球科技引领企业”

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

CES 2026 | 重大更新:NVIDIA DGX Spark开启“云边端”模式

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

研究发现商业AI模型可完整还原《哈利·波特》原著内容

Razer在2026年CES展会推出全息AI伴侣项目

CES 2026:英伟达新架构亮相,AMD发布新芯片,Razer推出AI奇异产品

通过舞蹈认识LimX Dynamics的人形机器人Oli

谷歌为Gmail搜索引入AI概览功能并推出实验性AI智能收件箱

DuRoBo Krono:搭载AI助手的智能手机尺寸电子阅读器

OpenAI推出ChatGPT Health医疗问答功能

Anthropic寻求3500亿美元估值融资100亿美元