腾讯混元发布并开源图像模型2.1,支持原生2K生图

9月9日深夜,腾讯发布并开源混元最新的生图模型“混元图像2.1(HunyuanImage 2.1)” 。该模型综合能力业界领先,支持原生2K高清生图。

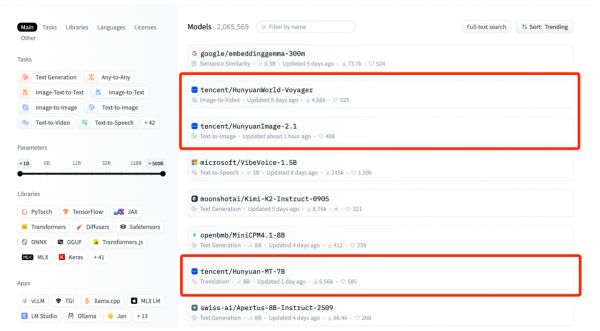

混元图像2.1模型在开源后,在Hugging Face模型热度榜热度迅速攀升,一跃而成全球第三热门模型。在该榜单前八名中,腾讯混元模型家族包揽三席。

同时,腾讯混元团队透露,即将发布原生多模态图像生成模型。

混元图像2.1在2.0架构的基础上全面升级,更加注重生成效果与性能之间的平衡。新版本不仅支持中英文的原生输入,还能够实现中英文文本与复杂语义的高质量生成。同时,在生成图片的整体美学表现和适用场景的多样性方面,都有了显著提升。

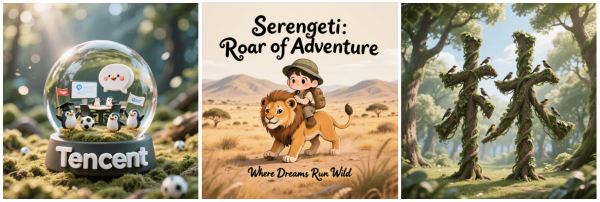

这意味着,设计师、插画师等视觉创作者能够更加高效、便捷地将自己的创意转化为画面。无论是生成高保真的创意插画,还是制作包含中英文宣传语的海报和包装设计,亦或是复杂的四格漫画与连环画,混元图像2.1都能为创作者提供快速、高质量的支持。

混元图像2.1是一款全面开源的基座模型,不仅具备业界领先的生成效果,还能够灵活适配社区多样化的衍生需求。目前,混元图像2.1的模型权重和代码已在Hugging Face、GitHub等开源社区正式发布,个人和企业开发者均可基于这一基础模型开展研究,或开发各类衍生模型与插件。

得益于更大规模的图文对齐数据集,混元图像2.1在复杂语义理解和跨领域泛化能力上有了显著提升。它支持最长达1000个tokens的提示词,可精准生成场景细节、人物表情和动作,实现多物体的分别描述与控制。此外,混元图像2.1还能够对图像中的文字进行精细控制,使文字信息与画面自然融合。

(混元图像2.1亮点1:模型对复杂语义理解能力强,支持多主体分别描述与精确生成。)

(混元图像2.1亮点2:对图像中的文字和场景细节的把控更为稳定。)

(混元图像2.1亮点3:支持风格丰富,如真人、漫画与搪胶手办等,并具备较高美感。)

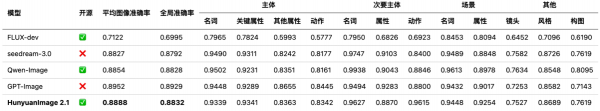

腾讯混元图像模型2.1处于开源模型中的SOTA水平。

从 SSAE(Structured Semantic Alignment Evaluation) 的评估结果上看,腾讯混元图像模型2.1在语义对齐上目前达到了开源模型上最优的效果,并且非常接近闭源商业模型 (GPT-Image) 的效果。

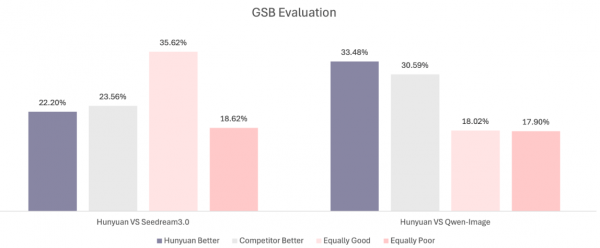

同时,GSB(Good Same Bad) 评测结果表明,HunyuanImage 2.1的图像生成质量与闭源商业模型Seedream3.0相当,同时相较于同类开源模型Qwen-Image略优。

混元图像2.1模型不仅采用了海量训练数据,还利用结构化、不同长度、内容多样的caption,极大提升了对文本描述的理解能力。在caption模型中,引入了OCR和IP RAG专家模型,有效增强了对复杂文字识别和世界知识的响应能力。

为大幅降低计算量、提升训练和推理效率,模型采用了32倍超高压缩倍率的VAE, 并使用dinov2对齐和repa loss来降低训练难度。因此,模型能高效原生生成2K图。

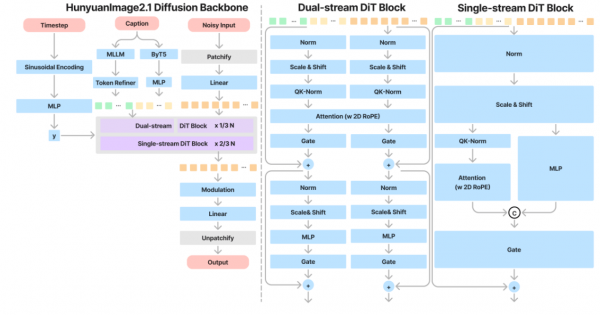

在文本编码方面,混元图像2.1配备了双文本编码器:一个MLLM模块用于进一步提升图文对齐能力,另一个ByT5模型则增强了文字生成表现力。整体架构为17B参数的单/双流DiT模型。

此外,混元图像2.1还在17B参数量级的模型上解决了平均流模型(meanflow)的训练稳定性问题,将模型推理步数由100步蒸馏到8 步,显著提升推理速度的同时保证了模型原有的效果。

同步开源的混元文本改写模型(PromptEnhancer)是业内首个系统化、工业级的中英文改写模型,能够对用户的文本指令进行结构化优化,丰富视觉表达,使改写后的文本生成图像的语义表现得到大幅提升。

腾讯混元在图像生成领域持续深耕,曾发布首个开源的中文原生DiT架构图像大模型——混元DiT,以及业界首个商用级实时生图模型——混元图像2.0。此次推出的原生2K模型混元图像2.1则在效果与性能之间实现了更好的平衡,能够满足用户和企业在多样化视觉场景下的多种需求。

同时,腾讯混元坚定拥抱开源,陆续开放了多种尺寸语言模型,图像、视频、3D等完整多模态生成能力和工具集插件,提供接近商业模型性能的开源基座。图像、视频衍生模型数量总数达到3000个,混元3D系列模型社区下载量超过230万,已成为全球最受欢迎的3D开源模型。

来源:至顶网软件与服务频道

好文章,需要你的鼓励

奥运级别的努力:首席信息官为2026年AI颠覆做准备

AI颠覆预计将在2026年持续,推动企业适应不断演进的技术并扩大规模。国际奥委会、Moderna和Sportradar的领导者在纽约路透社峰会上分享了他们的AI策略。讨论焦点包括自建AI与购买第三方资源的选择,AI在内部流程优化和外部产品开发中的应用,以及小型模型在日常应用中的潜力。专家建议,企业应将AI建设融入企业文化,以创新而非成本节约为驱动力。

字节跳动发布GAR:让AI能像人类一样精准理解图像任何区域的突破性技术

字节跳动等机构联合发布GAR技术,让AI能同时理解图像的全局和局部信息,实现对多个区域间复杂关系的准确分析。该技术通过RoI对齐特征重放方法,在保持全局视野的同时提取精确细节,在多项测试中表现出色,甚至在某些指标上超越了体积更大的模型,为AI视觉理解能力带来重要突破。

Spotify推出AI播放列表功能让用户掌控推荐算法

Spotify在新西兰测试推出AI提示播放列表功能,用户可通过文字描述需求让AI根据指令和听歌历史生成个性化播放列表。该功能允许用户设置定期刷新,相当于创建可控制算法的每周发现播放列表。这是Spotify赋予用户更多控制权努力的一部分,此前其AI DJ功能也增加了语音提示选项,反映了各平台让用户更好控制算法推荐的趋势。

Inclusion AI推出万亿参数思维模型Ring-1T:首个开源的超大规模推理引擎如何重塑AI思考边界

Inclusion AI团队推出首个开源万亿参数思维模型Ring-1T,通过IcePop、C3PO++和ASystem三项核心技术突破,解决了超大规模强化学习训练的稳定性和效率难题。该模型在AIME-2025获得93.4分,IMO-2025达到银牌水平,CodeForces获得2088分,展现出卓越的数学推理和编程能力,为AI推理能力发展树立了新的里程碑。

为全天候绿电而生,海辰储能发布全球首个原生8小时长时储能解决方案

为AI+而生,海辰储能发布全球首款锂钠协同AIDC全时长储能解决方案

长时储能开启智慧未来:海辰储能生态日全球首发三大新品

Arm 借助融合型 AI 数据中心,重塑计算格局

奥运级别的努力:首席信息官为2026年AI颠覆做准备

Spotify推出AI播放列表功能让用户掌控推荐算法

Adobe押注生成式AI获得回报,年度营收创历史新高

OpenAI与迪士尼达成十亿美元合作协议,米老鼠和漫威角色进入Sora

甲骨文150亿美元数据中心投资导致股价下跌

Spoor鸟类监测AI软件需求飞速增长

制药行业AI数据质量危机:垃圾进垃圾出的隐患

Harness获得2.4亿美元融资,估值达55亿美元,专注自动化AI编码后的开发流程