全球计算机系统领域“奥运会”SOSP公布最佳论文 “星绽”OS入选

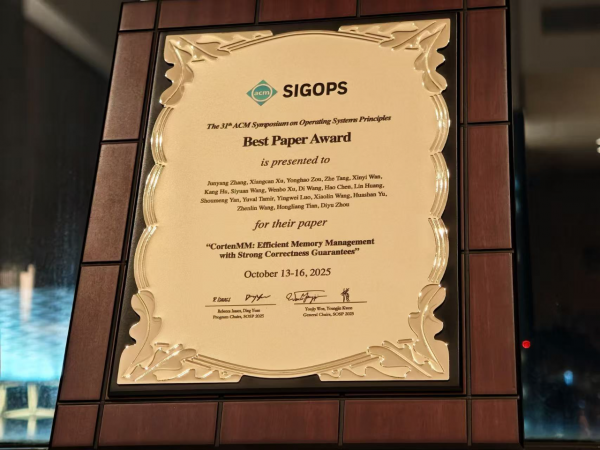

近日,被誉为全球计算机系统领域“奥运会”的顶级学术会议SOSP 2025公布奖项评选结果,“星绽”开源操作系统在高可扩展内存管理方面的研究论文,斩获今年的最佳论文奖(Best Paper Award)。据悉,本届SOSP会议共收到368篇投稿,最终录用66篇,其中最佳论文奖仅设三席。这标志着星绽OS在破解操作系统“性能与安全兼顾”这一难题上的探索,获得了国际学术界的认可。

“星绽”(Asterinas)是由中关村实验室、蚂蚁集团、北京大学、南方科技大学等机构联合发起,并在2024年10月22日向全球开发者开源,聚焦于安全可信底层技术的开源系统软件栈。星绽系统软件栈包括星绽OS、星绽机密计算两大项目,其中星绽OS内核作为下一代工业强度的开源通用OS内核,兼顾性能和安全,采用首创的框内核架构和新兴的Rust编程语言,支持x86和RISC-V等CPU体系架构,不仅兼容Linux内核,还在安全性方面有望大幅领先于Linux和其他现有主流OS。

据悉,SOSP始于1967年,与它的姊妹会议OSDI 一起,被全球学术界和工业界公认为操作系统和系统软件领域最高水平、最权威、最具影响力的顶级会议,被称为计算机系统领域的“奥运会”。SOSP/OSDI也深受全球科技公司的重视,Google、Microsoft、Meta、Amazon、Apple等科技公司会派遣核心研发人员参会、投稿及做报告等。许多在工业界产生巨大影响的项目,其核心论文都发表在SOSP/OSDI上。目前,SOSP/OSDI已经成为衡量一个研究机构或团队在系统领域是否处于世界领先水平的关键标尺,是孕育颠覆性计算技术的摇篮。

现代内存管理系统长期存在的两大痛点:性能瓶颈与并发安全。本次获奖论文《CortenMM: Efficient Memory Management with Strong Correctness Guarantees》,阐释了星绽操作系统的独创技术CortenMM在这一领域的探索。该文由北京大学、中关村实验室、蚂蚁集团、CertiK公司、加州大学洛杉矶分校、密歇根理工大学等共同合作完成。

论文提出,传统操作系统如Linux普遍采用“软件—硬件”两级抽象设计,好处是在很大程度上保证了操作系统在不同硬件平台之间的可移植性,但显著的同步开销严重制约多核处理器的性能发挥,而潜在的并发漏洞则带来安全风险。

研究团队发现,x86、ARM和RISC-V等几种主流指令集架构在其内存管理单元(MMU)的设计上已经趋于统一,因此过去为屏蔽硬件差异而存在的软件抽象层已不再是必需品。基于这一关键判断,星绽创新成果CortenMM摒弃了独立的软件抽象层,实现了一种“单层抽象”的全新系统架构,使应用程序能直接与经过硬件强化的接口进行交互。

CortenMM的简化设计带来了显著的性能提升,其同步正确性也得到了研究验证。通过消除软件层的额外同步开销,CortenMM的性能得到释放,在真实应用场景下,性能最高可达Linux的26倍。通过创新性地引入统一的事务化接口(Transactional Interface),利用Rust语言自身的安全特性,并结合先进的形式化验证工具(Verus)进行严格推演,研究团队成功证明了CortenMM核心并发代码的正确性,从根本上杜绝了复杂的并发漏洞。

2024年10月,“星绽”对外发布并向全球开发者开源。一年来,星绽开源操作系统三篇论文被顶会收录,除了CortenMM的研究论文入选SOSP 2025外,星绽两篇论文被顶级会议USENIX ATC 2025同时录用。此外,星绽在GitHub平台斩获逾3600颗Star,并登上HackerNews和LWN.net等国外主流技术社区头条,获2025年OS2ATC大会“最具影响力开源创新贡献奖”。

好文章,需要你的鼓励

让AI看图功能瘦身90%:希腊塞萨洛尼基大学发现图像修复“中奖彩票“神经网络

希腊塞萨洛尼基大学研究团队开发出MIR-L算法,通过"彩票假说"发现大型图像修复网络中的关键子网络。该算法采用迭代剪枝策略,将网络参数减少90%的同时保持甚至提升修复性能。MIR-L能同时处理去雨、去雾、降噪等多种图片问题,为资源受限设备的实时图像处理提供了高效解决方案,具有重要的实用价值和环保意义。

人工智能使用大揭秘:OpenRouter公司百万亿规模数据分析报告

这项由OpenRouter公司团队和Andreessen Horowitz(a16z)投资机构联合开展的研究,于2025年12月发表。

卡内基梅隆大学提出DistCA:让AI训练告别“木桶效应“的神奇技术

卡内基梅隆大学团队提出DistCA技术,通过分离AI模型中的注意力计算解决长文本训练负载不平衡问题。该技术将计算密集的注意力任务独立调度到专门服务器,配合乒乓执行机制隐藏通信开销,在512个GPU的大规模实验中实现35%的训练加速,为高效长文本AI模型训练提供了新方案。

NVIDIA Nemotron 3 系列开放模型: 击穿AI“工程墙”开启“Agentic AI”的“Linux时刻”

W.AWARDS金网奖2026未来商业计划领航秀峰会收官

人工智能使用大揭秘:OpenRouter公司百万亿规模数据分析报告

智能化与全球化并进,IBM中国下一个40年思考

通用汽车推出原生Apple Music应用并支持空间音频

GMV推进卫星导航技术助力自动驾驶运输与物流发展

英伟达考虑增产H200芯片满足中国市场激增需求

IBM推出开源智能体CUGA 任务完成率超五成

OpenAI支持的生物技术公司Chai Discovery获1.3亿美元B轮融资

八问智能时代:西云数据的八个答案

塑造2026年的八大智能手机趋势

AI架构师荣获《时代》杂志年度人物称号

推理性能提升10倍!蚂蚁集团开源业内首个高性能扩散语言模型推理框架dInfer

蚂蚁发布万亿参数旗舰模型Ling-1T,开启蚂蚁百灵大模型2.0版

谷歌宣布2026年合并Android与ChromeOS操作系统

Zorin OS 18 测试版让Linux看起来不像Linux

蚂蚁数科提出隐私保护AI新算法,可将推理效率提升超过100倍

Linux系统进化论:从内核创新看网络安全防护未来

从预测到增效:蚂蚁数科升级推出能源时序大模型EnergyTS 2.0

Linux Mint加速发布计划,LMDE 7与Wayland就绪的Cinnamon即将到来

Arm64架构Linux的UEFI安全启动现状分析

三个替代内核项目证明开发者并非只能依赖Linux