苹果携手IBM将机器学习引入企业iOS设备

苹果公司和IBM推出了一系列新的集成化产品,旨在扩展双方现有的协议,把更多企业应用带入iOS设备中。

首先,苹果和IBM把各自的人工智能和机器学习技术连接起来,让企业级iOS应用变得更加智能化。双方还提供了一个新的开发者控制台,让Swift开发者可以利用IBM Cloud构建易于编码的应用。

在人工智能方面,IBM的Watson AI系统将与苹果的Core ML相结合,打造一款名为IBM Watson Services for Core ML的新产品。

该框架旨在帮助开发者创建能够从用户活动中学习、通过每次互动变得越来越聪明的企业应用。IBM Watson作为一组基于云的服务提供给客户,而Core ML则将机器学习带入苹果设备上的应用。

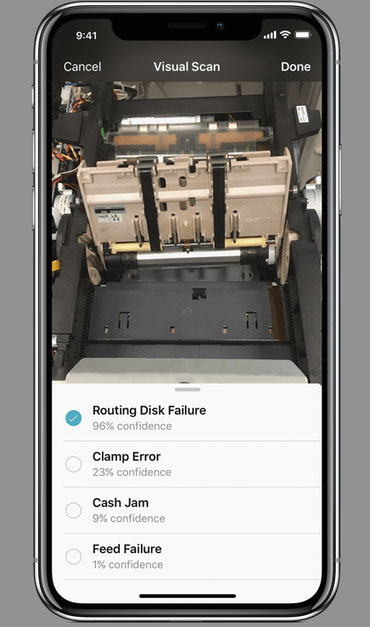

IBM表示,Watson Visual Recognition Service是一种基于数千个图像构建的视觉识别模型,也是这次集成推出的第一款可用模型,现在该模型可以导出到Core ML并在苹果设备上运行。最重要的是,开发者可以将经过训练的Core ML模型部署到iOS应用中,而无需任何代码或调用服务器。

至于开发者控制台,IBM表示这个控制台将为所有体验级别的开发者提供增强的分步指导,同时集成针对Swift优化的人工智能、数据和移动服务。

IBM首席执行官Ginny Rometty在拉斯维加斯举行的IBM Think大会主题演讲中表示:“这是一次巨大的整合,也是唯一一次。”

两家公司表示,可口可乐公司是第一家测试这个先进机器学习服务的企业,他们正在研究如何利用IBM Watson Service将人工智能应用于现场工作人员的原型,包括使用视觉识别、认知诊断和增强修复。

对于苹果而言,这次扩大与IBM的合作伙伴关系,与其致力于通过定制云应用让苹果设备吸引更多企业客户的目标是一致的。苹果和其他设备制造商面对智能手机和平板电脑的消费需求萎缩,也使得推动这些举措变得更加紧迫。

苹果公司产品营销副总裁Brian Croll表示:“我们的目标是帮助企业重新设计他们的工作方式。”

“Core ML让开发者可以轻松地将机器学习带入他们的应用,而无需成为这方面的专家。Core ML在本地运行模型,速度超快,同时可以保护隐私,因为敏感信息都保存在设备上。我们相信Core ML和Watson Services的结合,将有助于推动下一代智能企业应用的发展。”Croll这样说到。

好文章,需要你的鼓励

人工智能落地“最后一公里”,戴尔工作站助力AI应用提速

英特尔携手戴尔以及零克云,通过打造“工作站-AI PC-云端”的协同生态,大幅缩短AI部署流程,助力企业快速实现从想法验证到规模化落地。

意大利ISTI研究院推出Patch-ioner:一个神奇的零样本图像描述框架,让电脑像人一样描述任何图像区域

意大利ISTI研究院推出Patch-ioner零样本图像描述框架,突破传统局限实现任意区域精确描述。系统将图像拆分为小块,通过智能组合生成从单块到整图的统一描述,无需区域标注数据。创新引入轨迹描述任务,用户可用鼠标画线获得对应区域描述。在四大评测任务中全面超越现有方法,为人机交互开辟新模式。

阿联酋MBZUAI发布PAN世界模型,AI仿真技术迎来突破

阿联酋阿布扎比人工智能大学发布全新PAN世界模型,超越传统大语言模型局限。该模型具备通用性、交互性和长期一致性,能深度理解几何和物理规律,通过"物理推理"学习真实世界材料行为。PAN采用生成潜在预测架构,可模拟数千个因果一致步骤,支持分支操作模拟多种可能未来。预计12月初公开发布,有望为机器人、自动驾驶等领域提供低成本合成数据生成。

MIT团队重磅发现:不配对的多模态数据也能让AI变得更聪明

MIT研究团队发现,AI系统无需严格配对的多模态数据也能显著提升性能。他们开发的UML框架通过参数共享让AI从图像、文本、音频等不同类型数据中学习,即使这些数据间没有直接对应关系。实验显示这种方法在图像分类、音频识别等任务上都超越了单模态系统,并能自发发展出跨模态理解能力,为未来AI应用开辟了新路径。

《2025 中国企业级 AI 实践调研分析年度报告》:深度剖析与价值洞察

Gartner:在中国构建AI软件工程技能的三大举措

阿联酋MBZUAI发布PAN世界模型,AI仿真技术迎来突破

Nvidia和Google支持的AI代码编辑器Cursor获23亿美元融资

Anthropic披露首例Claude模型参与的AI网络间谍活动

Cadence首款系统芯粒架构成功流片,助力物理AI发展加速

百度发布定制AI加速器响应国产芯片需求

VasEdge试用火热招募,降本增效机遇来袭

Infinidat InfiniBox G4系列升级重塑高端企业存储格局

Avalonia为微软MAUI跨平台应用方案带来Linux和浏览器支持

谷歌DeepMind发布SIMA 2智能体:游戏世界中学习迈向AGI之路

Infinidat G4系列升级重新定义高端企业存储格局