Runway的AI视频魔法:唤起脑海深处的原力

你可曾记得20 世纪 80 年代每当麦当娜在她的巡回演唱会中每次奏响热门歌曲“La Isla Bonita”时,她身后的巨大舞台屏幕上就会播放出超现实的“夕阳下云彩”的移动图像?

如今,如果也想“只需输入文字”就能将你脑海中的景象转变成视频,其最简单的方法是通过Runway发布的从文本到视频模型工具来制作视频。

Runway AI 是来自纽约一家名为 Runway 的初创公司的基于人工智能的工具集合。在这些工具中,Runway Gen-1 是一个 AI 视频到视频的 AI 生成器,通过现有视频,将 AI 效果应用于已有媒体。因此,需要提供一个基础视频供模型执行其后续工作。而 Runway Gen-2 是一个 AI 文本/图像到视频的生成器。不需提供任何视频,它可以接受图像或文本作为提示,并按照这些提示生成视频。

凭空创作视频最简单的方式就是用Gen-2通过提供一段文字,就可以为你生成一段视频。

可以访问:https://runwayml.com/来体验这两个模型,选择相应的模型输入提示词就可以根据需要修改的设置并生成你想要的视频。

Runway提供了很多基于人工智能的编辑工具,包括:视频到视频(Gen-1)、文本/图像转视频(Gen-2)、删除背景、文字转图像、图像到图像、训练你自己的生成器、无限影像、展开图片、帧插值、擦除和替换、背景混音、图像变化、3D捕捉、3D纹理、修复、颜色等级 (LUT)、超慢动作、模糊脸部、景深、场景检测、提取深度、干净的音频、消除沉默等

今天,我们就用最简单的方式体验生成视频这个功能。就拿我喜欢的一首歌做为示例,这首歌就是《You Raise Me Up》它鼓舞了许多暂时深处困境并无法自拔人。其旋律从舒缓到振奋,层层递进,让人逐渐摆脱出当前的悲伤与孤单,勇敢迎接必将光明的明天!

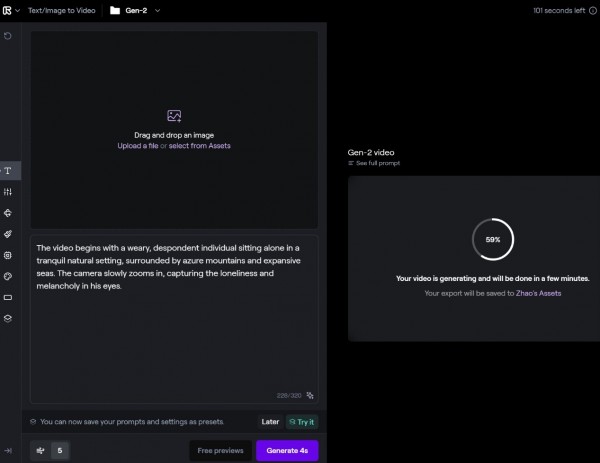

首先我们把要把这首歌词变成Gen-2模型能理解的提示。如果你觉得这一步可能比较费脑子的话,我们也可让GPT-4来帮忙。GPT根据歌词给出的提示词是:

视频开始于一位疲惫、失落的人物独自坐在宁静的自然环境中,四周被蔚蓝的山峦和宽广的海洋包围。镜头慢慢拉近,捕捉到他的眼神中流露出的孤独与忧郁。

画面转换,出现一个亲切的人物静静地走到他身边坐下,温暖的手臂环绕着他的肩膀。这一举动带来安慰和力量,他的眼神开始显露出希望和决心。

随着音乐的升华,画面展示这位人物站立起来,在他的亲友的支持下,他开始攀爬高山,勇敢地面对暴风雨中的惊涛骇浪。镜头中,他从山顶望向远方,面对风暴的海面,彰显出内心的力量和勇气。

画面再次转变,展示他在亲友的肩膀上看向更远的地方,似乎触及了生命的极限。此时,画面捕捉到他们共同的笑容,体现出相互支持和无私的爱。

最终画面,随着夕阳的落下,他们一起在海边行走,每个人的心中都有着不同的饥渴,但共同的体验让他们感受到生活的完整和奇迹。随着镜头的拉远,音乐缓缓降低,留下一种宁静而充满希望的氛围。

其英文:

The video begins with a weary, despondent individual sitting alone in a tranquil natural setting, surrounded by azure mountains and expansive seas. The camera slowly zooms in, capturing the loneliness and melancholy in his eyes.

The scene transitions to a kind figure quietly walking over and sitting beside him, with warm arms wrapping around his shoulders. This gesture brings comfort and strength, and hope and determination start to shine in his eyes.

As the music swells, the scene shows the individual standing up, with the support of his loved one, he begins to climb mountains and bravely faces the stormy seas. From the mountaintop, he looks into the distance, confronting the tempestuous ocean, demonstrating inner strength and courage.

The scene shifts again, showing him on the shoulders of his friend, looking toward even greater distances, seemingly reaching beyond the limits of life. At this moment, the camera captures their shared smiles, reflecting mutual support and selfless love.

In the final scene, as the sun sets, they walk together along the seaside, each with different yearnings in their heart, but the shared experience brings a sense of completeness and wonder to their lives. As the camera pulls away and the music slowly fades, a serene and hopeful atmosphere lingers.

这有5段文字,也就是需要用5个场景来呈现。所以我们需要一个场景一个场景的去生成。

注册好进入主页面:

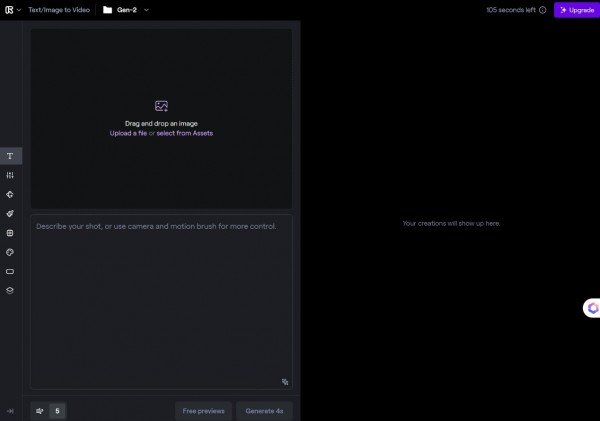

进入Gen2模型页面:

我们可以看到,它既可以根据你有的视频资产生成视频也可以通过文字,我们这次采用文字生成视频。

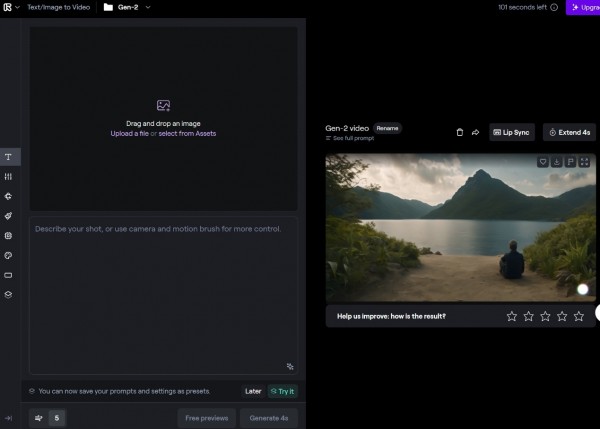

插入第一段文字后就会生成第一个场景。模型会为你产生一段4S 的视频。视频会呈现在右侧,生成好的视频就可以下载并保存。

最后可以将5段生成好的视频进行拼接,或者再用Gen1模型继续AI拓展、丰富,希望有兴趣的读者朋友们能继续探索……

今天,生成视频已十分简单、便捷,但人工智能生成的最长视频仍然是以秒计,经常会出现抖动动作和明显的缺陷:如扭曲的手和面部。相信随着技术的不断进步,这些问题会得到很好的改善。

好文章,需要你的鼓励

IBM大型机本月获得Spyre AI加速器升级

IBM Spyre加速器将于本月晚些时候正式推出,为z17大型机、LinuxONE 5和Power11系统等企业级硬件的AI能力提供显著提升。该加速器基于定制芯片的PCIe卡,配备32个独立加速器核心,专为处理AI工作负载需求而设计。系统最多可配置48张Spyre卡,支持多模型AI处理,包括生成式AI和大语言模型,主要应用于金融交易欺诈检测等关键业务场景。

加拿大女王大学:开源AI生态系统中的“版权炸弹“即将引爆?

加拿大女王大学研究团队首次对开源AI生态系统进行端到端许可证合规审计,发现35.5%的AI模型在集成到应用时存在许可证违规。他们开发的LicenseRec系统能自动检测冲突并修复86.4%的违规问题,揭示了AI供应链中系统性的"许可证漂移"现象及其法律风险。

Ganiga将在TechCrunch Disrupt展示AI垃圾分拣机器人

意大利初创公司Ganiga开发了AI驱动的智能垃圾分拣机器人Hoooly,能自动识别并分类垃圾和可回收物。该公司产品包括机器人垃圾桶、智能盖子和废物追踪软件,旨在解决全球塑料回收率不足10%的问题。2024年公司收入50万美元,已向谷歌和多个机场销售超120台设备,计划融资300万美元并拓展美国市场。

语音识别遇上“扩散大脑“:剑桥-清华-伊利诺伊团队让机器听得更准确

这项由剑桥大学、清华大学和伊利诺伊大学合作的研究首次将扩散大语言模型引入语音识别领域,开发出Whisper-LLaDA系统。该系统具备双向理解能力,能够同时考虑语音的前后文信息,在LibriSpeech数据集上实现了12.3%的错误率相对改进,同时在大多数配置下提供了更快的推理速度,为语音识别技术开辟了新的发展方向。

API安全:守护智能边缘的未来

Solidigm 成立AI中央实验室,配备高性能、大密度存储测试集群

智慧城市的绿色引擎:从楼宇到数据中心的可持续之路

IBM大型机本月获得Spyre AI加速器升级

Ganiga将在TechCrunch Disrupt展示AI垃圾分拣机器人

新加坡昇菘集团获批自动驾驶车队运营供应链

思科新路由器将分散数据中心整合为AI训练集群

CoreWeave推出无服务器强化学习平台降低企业AI成本

当年只有30人在训练AGI:Anthropic预训练负责人访谈的万字实录,曾经的AI实验室都是通才,现在大家都是专才

NBA中国与阿里云宣布达成多年合作,重塑球迷互动体验

PEC 2025 AI创新者大会年度提问:新工作时代:AI工作流由谁主导?

PEC 2025 AI创新者大会年度对话:新创意时代,AI如何定义“第十艺术”?

最热门的 AI 模型:它们的功能和使用方法

这款古怪的 AI 智能手机可以创建你的数字分身

Faireez 获 750 万美元融资,为租赁市场提供 AI 驱动的酒店式管家服务

Broadcom 大获全胜:70% 大型 VMware 客户购买其最全面解决方案

Peer 获得1050万美元元宇宙引擎投资,推出3D个人星球功能

获 3000 万美元融资,Crogl 发布面向安全分析师的全新 AI "钢铁侠战衣"

Turing 获得 1.11 亿美元融资,估值达到 22 亿美元,为 OpenAI 等大语言模型公司提供关键代码支持

Tavus 推出系列 AI 模型,实现实时人脸交互技术突破

Welevel 获得 570 万美元融资,革新程序化游戏开发

AI 驱动的卓越运营:企业如何通过人人可及的流程智能提升成功