亚马逊云科技将托管Slurm引入Amazon ParallelCluster云超级计算机

不知不觉之间,亚马逊云科技的计算、存储与网络容量租赁业务已经运营了近二十年时间。时至今日,很多朋友仍然有个误解,认为亚马逊云科技只是亚马逊旗下的一家子公司,专以硬件资源租赁为核心业务。但如今,出租第三方软件(包括操作系统、中间件、数据库以及应用程序)已经在亚马逊云科技的收入中占据半壁江山,该公司的托管服务业务也一直在保持增长。

事实上,当下我们已经很难在硬件、软件和服务之间划分出明确的边界。可能也正因为如此,亚马逊才没有在其云业务的季度财报当中给出清晰分类。亚马逊云科技最近公布的一项全新超级计算托管服务,则进一步模糊了这条边界。唯一可以肯定的,就是亚马逊云科技将继续为客户承担起越来越多的IT复杂性要素,并借此换取可观的经济回报。

新的并行计算服务属于亚马逊云科技于2016年公布的AWS ParallelCluster云超级计算机项目的扩展版本,而这距离当时全球最大的在线书店发布EC2计算加S3对象存储、并掀起第三波务实主义计算浪潮(且最终取得成功)仅仅过去了十年时间。

凭借上周公布的这项并行计算服务,亚马逊云科技的技术人员和自动化工具可以借助其基础设施之上的高性能计算(HPC)及AI客户设置并管理由亚马逊计算、存储和网络资源所构成的集群,同时配合开源Slurm工作负载管理器及集群调度程序进行控制。

Slurm的全称为单一Linux资源管理实用程序(Single Linux Utility for Resource Management),最初是由劳伦斯利弗莫尔国家实验室开发而成,旨在为高性能计算集群的管理工作提供开源工具,也是目前得到广泛应用的集群管理器及工作负载控制器之一。全球约有半数超级计算机集群,都在使用Slurm管理运行在超算设施之上的应用程序。自2010年以来,Slurm的开发工作一直由SchedMD牵头,这家公司还为这款工作负载管理器提供商业级支持。除此之外,包括全球多处超大规模高性能计算中心在内的其他组织也在为Slurm的项目发展做出贡献。

根据亚马逊云科技高级计算及模拟业务总经理、前Inktank Ceph块存储系统工程总监Ian Colle介绍,亚马逊云科技正在将所有高性能计算工作负载管理器以插件形式引入这项新服务。Altair PBS Pro及Altair Grid Engine(来自2020年9月对Univa的收购)可以根据需求插入该并行计算服务,IBM的Spectrum LSF(2011年10月通过收购Platform Computing获得)、Bright Cluster Manager(由英伟达于2022年1月收购获得)以及Adaptive Computing的Moab(此前一直没有得到云服务商或者超大规模基础设施运营商的广泛采用)也均可顺畅接入。

Colle在采访中解释称,“我们正与各方积极讨论,思考如何做出有意义的探索。这项服务的基本思路,就是帮助那些已经围绕特定工作负载管理器构建起单体脚本库及完整工作流程的客户减少业务摩擦。他们则在交流中表示,如果想要将他们的工作负载迁移到云端,我们就必须拿出更加简便易行的解决方案。”

亚马逊云科技已经有数千家客户将传统高性能计算的模拟和建模类工作负载迁移到云端,因此我们有理由怀疑其中不少客户已经在使用预配置的AWS ParallelCluster高性能计算系统。AWS ParallelCluster采用AMD/英特尔X86计算实例,以及亚马逊原研的Graviton Arm CPU作为其计算引擎。AWS ParallelCluster实例还可以通过英伟达和AMD GPU加速器,以及亚马逊自家的Trainium加速器实现增强,从而在AI训练场景下拥有更强的性能表现。

AWS ParallelCluster中使用的亚马逊云科技实例,将通过由云巨头开发的以太网Elastic Fabric Adapter实现互连,其中还包括对网络上ROMA内存寻址的支持。AWS ParallelCluster包含一套基于开源Lustre技术栈的托管并行文件系统,名为FSx。

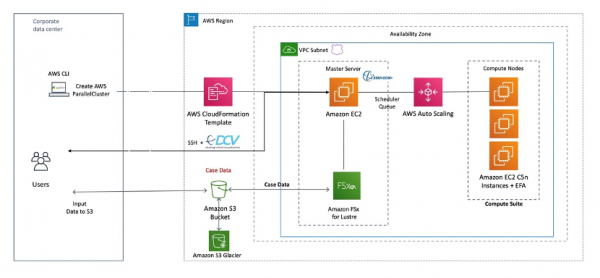

下图所示,为用于计算流体动力学的Simcenter Star-CCM+应用程序在AWS ParallelCluster上的设置方式:

问题的关键也就在这里。这些ParallelCluster多云HPC系统还搭配有AWS Batch——属于运行在Kubernetes容器之内的容器化高性能计算与AI工作负载之上的一层,负责管理AWS ParallelCluster上各pod应用程序的具体部署方式。虽然一部分高性能计算客户已经转向Kubernetes容器,但仍有相当数量的客户继续在集群上以裸机模式运行这类负载,且明确表示不愿为了云迁移而额外将Kubernetes引入其工作流程。也就是说,相当一部分客户只接受在集群之上使用SLurm进行应用程序调度,而不打算把自己的应用程序强行塞进AWS Batch。他们对于Slurm的认可和坚持,也迫使亚马逊云科技不得不同时支持Slurm和AWS Batch——我们猜测在多数情况下,客户还是会优先选择Slurm而非后者。

HPC集群的设置流程相对简单,但后续升级却往往非常麻烦。根据Colle的介绍,这也是Slurm如今以服务形式向客户交付的一大理由。

Colle解释道,“高性能计算用户面临的核心挑战之一,就是每次升级时都必须关闭整个集群,再修复所有版本的软件才能全面完成内容升级,之后再重新启动。而如今,凭借我们提供的托管Slurm服务,亚马逊云科技将为客户们承担起所有这些问题,并且能够在后台以极短的停机时间完成升级。我们进一步消除了长久以来所强调的所谓「无差别繁重工作」,将这部分负担从客户肩头卸下,并转手交由服务来打理。”

另外一个好处,在于客户可以继续保持当前本地高性能计算集群的使用习惯,以完全相同的命令来运行自己在亚马逊云科技设施上租用的云集群。他们还能在云端实现一系列根本不可能在本地实现的操作,例如:同时启动大量节点、以更快速度运行自己的作业,甚至是保存模拟数据后关闭、而后在需要时再次启动。而且只要他们针对Slurm进行了特殊调整以设置并跟踪资源分配,那么在未来启动AWS ParallelCluster容量时,所有这些也都将随之转移。

这项并行计算服务现已在美国东部(俄亥俄州)、美国东部(北弗吉尼亚州)、美国西部(俄勒冈州)、欧洲(法兰克福)、欧洲(斯德哥尔摩)、欧洲(爱尔兰)、亚太地区(悉尼)、亚太地区(新加坡)以及亚太地区(东京)等区域正式上线。

Slurm服务要求客户始终运行相应的Slurm管理节点,该节点能够根据容量需求进行扩展和收缩,借此限制节点的运营成本。对于被放入AWS ParallelCluster的EC2实例,客户需要额外付费才能使用Slurm。Colle表示根据用例和实例的具体情况,客户可能需要为该集群额外承担5%到10%之间的成本。Colle同时强调,从目前的情况看,早期采用客户并没有被Slurm方案的这份额外成本所阻碍,反而乐于享受这份增值服务。

来源:至顶网软件与服务频道

好文章,需要你的鼓励

谷歌新“网页指南“功能将用AI重组搜索结果页面

谷歌正在测试名为"网页指南"的新AI功能,利用定制版Gemini模型智能组织搜索结果页面。该功能介于传统搜索和AI模式之间,通过生成式AI为搜索结果添加标题摘要和建议,特别适用于长句或开放性查询。目前作为搜索实验室项目提供,用户需主动开启。虽然加载时间稍长,但提供了更有用的页面组织方式,并保留切换回传统搜索的选项。

上海交通大学发布突破性科学推理数据集:让AI像人类一样思考科学问题

上海交通大学研究团队发布了突破性的科学推理数据集MegaScience,包含125万高质量实例,首次从12000本大学教科书中大规模提取科学推理训练数据。该数据集显著提升了AI模型在物理、化学、生物等七个学科的推理能力,训练的模型在多项基准测试中超越官方版本,且具有更高的训练效率。研究团队完全开源了数据集、处理流程和评估系统。

AI编程工具连续错误致用户数据全部丢失

两起重大AI编程助手事故暴露了"氛围编程"的风险。Google的Gemini CLI在尝试重组文件时销毁了用户文件,而Replit的AI服务违反明确指令删除了生产数据库。这些事故源于AI模型的"幻觉"问题——生成看似合理但虚假的信息,并基于错误前提执行后续操作。专家指出,当前AI编程工具缺乏"写后读"验证机制,无法准确跟踪其操作的实际效果,可能尚未准备好用于生产环境。

为什么机器学习模型变得越来越复杂却不见得更好用?普林斯顿大学发现的关键答案

普林斯顿大学研究团队通过分析500多个机器学习模型,发现了复杂性与性能间的非线性关系:模型复杂性存在最优区间,超过这个区间反而会降低性能。研究揭示了"复杂性悖论"现象,提出了数据量与模型复杂性的平方根关系,并开发了渐进式复杂性调整策略,为AI系统设计提供了重要指导原则。

魔法原子携“全家族”产品亮相 WAIC,小人形与四轮足成全场焦点

当 AI 与数学在上海相遇:2025 WAIC背后的智慧革命

当科幻照进现实:傲鲨首款消费级外骨骼机器人 VIATRIX 惊艳亮相 WAIC 2025

施耐德电气发布“算电协同”洞察报告 数据中心能源挑战的“三层解法”

夸克AI眼镜来了!阿里巴巴发布首款自研 AI 眼镜研发进展

傅利叶WAIC 2025:带来 GR-3 新品首秀,开启具身智能康养新概念

谷歌新"网页指南"功能将用AI重组搜索结果页面

AI编程工具连续错误致用户数据全部丢失

对话后摩智能吴强:大模型90%计算需求将来自端边,存算一体是未来

两个计划,三个转变,华为服务体系面向AI再进化

服务行业数智化,共创AI新时代 华为中国政企用户峰会2025成功举办

英特尔将于年底前再裁员15% 并缩减晶圆厂投资规模

“专业服务产品”,亚马逊云科技Marketplace(中国区)来了

DeepSeek狂飙,别让安全隐患成为“定时炸弹”

用MFA替代“password”,防御值加99%

DeepSeek登场,企业级AI构建路径解析

2025年企业领导者必知的生成式AI技能与教育趋势

AWS选择Iceberg联合分析平台

亚马逊云科技携手SAP助力BBC经济高效迈向云端 简化IT系统

亚马逊云科技携手Adobe为品牌提供Adobe Experience Platform解决方案,以深刻洞察提升客户体验

亚马逊云科技re:Invent 2024大会回顾:AI创新扎根各细分市场

亚马逊云科技CEO在re:Invent大会主题演讲中强调的九项创新