AWS推出AMD第四代Epyc虚拟机,用于高性能计算和常规工作负载

AMD 的第四代 Eypc 处理器日前登陆 AWS,并提供通用和高性能计算(HPC)任务的选择。

第四代 Eypc虚拟机率先在亚马逊的 Hpc7a 实例上推出,据称针对计算和内存带宽受限的工作负载(如计算流体动力学和数值天气预报)进行了优化。亚马逊声称新实例的速度与使用 AMD 第三代 Epycs 的旧版套件 Hpc6a 实例相比快了 2.5 倍。

新的虚拟机提供 24、48、96 和 192 个内核的选择。通常情况下,列出的 vCPU 数量是指线程个数,但亚马逊称新虚拟机的同时多线程(SMT)已被禁用,目的是最大限度地提高性能。这意味着亚马逊使用的是一对 96 核 CPU,很可能是Epyc 9654,时钟频率可提升至 3.7GHz。

我们所知道的是,亚马逊并没有使用 AMD 的高速缓存堆叠 Genoa-X CPU。这些芯片是AMD芯片制造商在今年 6 月的数据中心和人工智能活动中推出的,可提供高达1.1GB的L3缓存。即使没有海量的额外 L3,AMD 的第四代 Epycs 也增加了许多功能,可能有益于HPC和基于人工智能的工作负载。这些功能包括支持 AVX-512、矢量神经网络指令 (VNNI)、BFloat 16 和更高的内存带宽(每个插槽最多 12 个 DDR5 通道)。

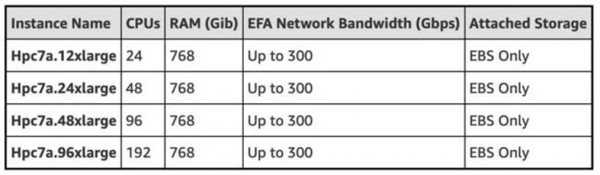

亚马逊的 Hpc7a 实例可配备四个 SKU,每个 SKU可 配备 24 到 192 个 vCPU

这些实例的内核个数是可以调整的(这将有利于那些按内核许可运行的工作负载),其余规格保持不变。所有四个 SKU 均配备了 768GB 内存以及由亚马逊弹性织物适配器提供的300Gbps节点间网络和25Gbps的外部带宽。

这种标配并非偶然。客户可以通过保持内存配置的一致性进而调整每个内核的内存或带宽的特定比例。这对于HPC工作负载非常有益,因为HPC工作负载更常受到内存带宽的限制,而不是内核数量的限制。其实并不是只有 AMD 的实例这样做,亚马逊在之前发布的基于 Graviton3E 的 Hpc7g 实例中也采用了同样的方法。

高速节点之间的网络也很重要,原因是亚马逊希望客户将工作负载分布到多个实例上运行,就像集群中的节点一样,而不是在单个虚拟机中运行。因此,这些节点支持亚马逊的 批量和平行集群(Batch and ParallelCluster)编排平台以及 Lustre FSx存储服务。

AWS 实例的性能得到提升

对于一些可能不需要最快时钟速度或内存带宽的用户,亚马逊还推出了早在 6 月份就预告过的 M7a 通用实例。

亚马逊声称这些实例的性能比基于 Epyc Milan 的 M6a VM 高出多达 50%,并且可以使用多达 192 个 vCPU,每个 vCPU的时钟频率可达3.7GHz。假设亚马逊在这些实例中使用了 SMT(我们已联系亚马逊以求澄清),这表明亚马逊很可能在这些实例中用了单个 Epyc 9654,最高频率恰好是 3.7GHz。

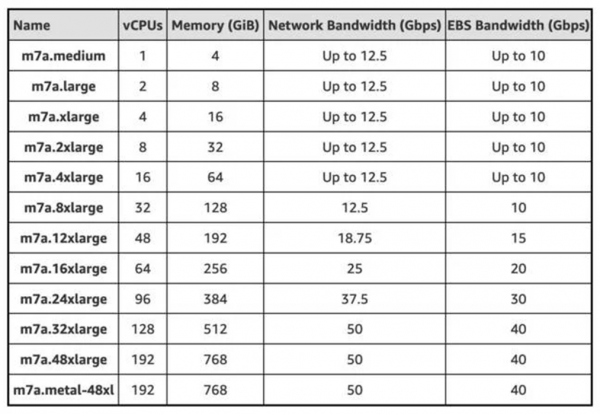

亚马逊的 M7a 实例包最多可配备 192 个 vCPU 和 768GB 内存

这些虚拟机的配置有十多种,从 1GB 内存和 12.5Gbps 网络带宽的单 vCPU到768GB 内存和 50Gbps 网络吞吐量的 192 vCPU 大型实例。

所有这些实例都由亚马逊的定制Nitro数据处理单元(DPU)支持,DPU可以卸载主机CPU的许多功能,如网络、存储和安全等等。

亚马逊的M7a实例现在已经在该云服务提供商美国的北弗吉尼亚、俄亥俄、俄勒冈和爱尔兰数据中心中提供给普通用户使用。

好文章,需要你的鼓励

Linux在CES 2026:企鹅系统依然活跃于物联网、汽车和AI领域

虽然在CES 2026展会上需要仔细寻找才能发现Linux的身影,但它确实无处不在。Canonical展示了与英伟达合作的Ubuntu Linux桌面超级计算机,配备GB10芯片、128GB内存和4TB存储。公司还演示了Ubuntu Core在IoT设备中的应用,以及为应对欧盟网络韧性法案推出的Ubuntu Pro设备支持方案。此外,Linux正成为软件定义汽车、边缘AI和智能电视的默认平台。

剑桥大学突破性研究:如何让AI在对话中学会真正的自信判断

剑桥大学研究团队首次系统探索AI在多轮对话中的信心判断问题。研究发现当前AI系统在评估自己答案可靠性方面存在严重缺陷,容易被对话长度而非信息质量误导。团队提出P(SUFFICIENT)等新方法,但整体问题仍待解决。该研究为AI在医疗、法律等关键领域的安全应用提供重要指导,强调了开发更可信AI系统的紧迫性。

Vibe Bot推出桌面AI智能体设备

智能白板制造商Vibe发布桌面AI设备Vibe Bot,集成语音助手、智能摄像头和AI笔记功能。该设备采用圆柱形设计,配备4K摄像头、波束成形麦克风和可旋转屏幕,能够跟踪发言者并自动调整视角。支持在线和离线会议录音,提供实时转录和AI生成的会议纪要,用户可通过语音助手查询会议信息并触发日历等应用操作。

威斯康星大学研究团队破解洪水监测难题:AI模型终于学会了“眼观六路“

威斯康星大学研究团队开发出Prithvi-CAFE洪水监测系统,通过"双视觉协作"机制解决了AI地理基础模型在洪水识别上的局限性。该系统巧妙融合全局理解和局部细节能力,在国际标准数据集上创造最佳成绩,参数效率提升93%,为全球洪水预警和防灾减灾提供了更准确可靠的技术方案。

NVIDIA创始人兼CEO黄仁勋荣获技术领域最高荣誉——2026年IEEE荣誉奖章

红帽深化与NVIDIA的合作,将企业级开源与机架级AI深度结合,加速实现可投入生产的创新

Linux在CES 2026:企鹅系统依然活跃于物联网、汽车和AI领域

Vibe Bot推出桌面AI智能体设备

Razer推出桌面AI动漫全息投影智能助手

Cloudera:构建符合伦理标准的AI,可信数据是关键

Nvidia发布Vera Rubin AI计算平台,性能大幅提升

7种削弱IT业务价值的致命做法

PTC在NRF 2026大会上发布AI驱动的FlexPLM新功能

如何终结针对IT部门的指责游戏

Windchill + Makersite,让可持续性从“理念”变为“行动”

Linux基金会领导者:我们并未处在AI泡沫中

AMD 发布新一代 AMD RDNA(TM) 4 架构,推出 AMD Radeon(TM) RX 9000 系列显卡

AWS亮相CES公布将AI引入汽车领域的合作成果

Nvidia和AWS联手加速云端AI部署

在re:Invent大会上,AWS聚焦企业人工智能,在Bedrock方面取得了进展,并推出了新模型

红帽扩展 AWS 联盟,提供更多 Ansible 和 OpenShift 产品

苏姿丰的十年历程回顾:AMD如何从英特尔廉价替代品成长为x86领域的有力竞争者

面临AMD及自身内部挑战,英伟达Green 500主导地位受到威胁

IBM宣布将最强大的Granite AI模型引入AWS云端

微软率先拿下HBM驱动的AMD CPU供货

AWS Lambda的十年历程:无服务器愿景塑造云和AI的未来