IBM和NASA宣布开源AI模型加快分析卫星数据

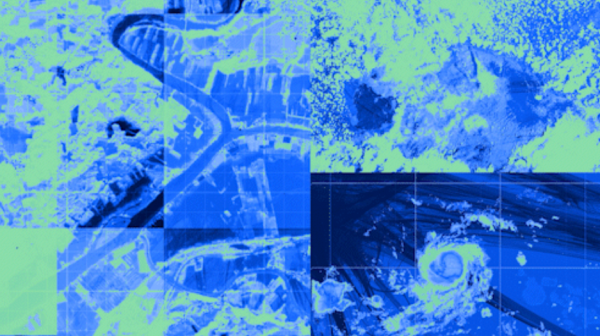

IBM和NASA近日发布了一款人工智能模型,帮助研究人员更快地分析卫星数据。

该模型在Hugging Face上提供,这是一个类似GitHub的流行平台,用于共享开源神经网络。IBM和NASA的下一阶段合作将重点把AI能力扩展到更多用例中,并与马萨诸塞州伍斯特市的克拉克大学合作开展该计划。

IBM研究院AI副总裁Sriram Raghavan表示:“开源技术加速了气候变化等关键领域的发现。”

IBM表示,这种新模型旨在帮助研究人员识别美国大陆可能面临洪水和野火风险的地区,并且分析地理空间数据的速度要比最先进的神经网络快四倍,训练所需的数据也更少。

IBM把这种AI称为一个基础模型,或者说是一个可以执行各种高级计算任务的模型。它基于Transformer架构,一种流行的神经网络设计方法。Transformer模型在推理一段数据时可以考虑大量上下文信息,这使其能够比其他AI系统做出更准确的决策。

这项技术支撑着市场上许多先进的AI系统,其中就包括OpenAI最新的大型语言模型GPT-4。

IBM和NASA在名为Harmonized Landsat Sentinel-2的地理空间数据集上联合训练了他们的模型,这个数据集包括由NASA Landsat-8 卫星拍摄的地球表面图像,以及来自欧洲航天局运营的卫星星座Sentinel-2的测量数据。

IBM使用其内部开发的Vela超级计算机训练这个AI模型。今年早些时候IBM推出的这套系统采用了Nvidia的A100系列数据中心图形芯片,Vela使用的是A100高端版本,具有特别大的板载内存池,用于存储AI模型。

除了Nvidia的芯片之外,Vela超级计算机还配备了IBM开发的虚拟化软件。虚拟化使某些AI开发任务变得更加容易,但这种简单性是以降低处理能力为代价的,不过IBM表示,它将性能影响降低到了5%以下,研究人员将其描述为“我们所知业内最低的开销”。

尽管IBM和NASA优化了他们的模型来检测有洪水和野火风险的区域,但他们估计该模型也可以适用于其他用例,例如跟踪森林砍伐行为,以及帮助研究人员监测碳排放并预测作物产量。

未来,IBM计划进一步扩展AI功能,IBM已经在与NASA和克拉克大学的研究人员合作进行这项工作。

在该计划中,IBM希望优化时间序列分割和相似性研究的模型,这是两种主流的数据分析方法,不仅用于地理空间研究,还用于一系列其他任务,例如,时间序列分割可用于研究股票价格波动的原因。

IBM最终计划通过Watsonx产品套件提供该模型的商业版本。Watsonx产品套件是在今年5月推出的,其中包括了一系列软件工具,旨在帮助企业构建先进的AI模型并将其部署到生产中,此外还有针对各种用例进行优化的预打包神经网络。

Watsonx是由Red Hat OpenShift AI提供支持的,后者是IBM机器学习产品组合中最近推出的另一个组件,是OpenShift应用开发和部署平台的一个版本,专门针对AI工作负载进行了优化,简化了监控生产中运行的机器学习模型的性能等任务。

好文章,需要你的鼓励

Facebook推出AI约会助手提升交友体验

Meta宣布为Facebook Dating推出AI聊天机器人助手,帮助用户找到更匹配的对象。该AI可根据用户需求推荐特定类型的匹配者,并协助优化个人资料。同时推出Meet Cute功能,每周提供算法选择的"惊喜匹配"。尽管18-29岁用户匹配数同比增长10%,但相比Tinder的5000万日活用户仍有差距。AI功能已成为约会应用标配,Match Group等竞争对手也在大力投资AI技术。

字节跳动全新RewardDance框架:让AI在“奖励舞蹈“中精进视觉创作能力

字节跳动团队提出RewardDance框架,首次系统性解决视觉生成中的奖励模型扩展问题。该框架通过将奖励预测转为生成式任务,并将模型规模扩展至260亿参数,同时集成任务指令、参考样例和推理能力,有效解决了"奖励作弊"问题。实验显示,在文本生成图像任务中质量提升10.7分,视频生成性能改善49%,达到行业领先水平,为AI视觉创作提供了更强大可靠的技术基础。

Neo4j支持新图查询标准,助力AI时代数据访问

Neo4j认为已找到让生成式AI访问图数据库记录的方法。图数据库专注于数据点之间的关系建模和查询,在欺诈检测、推荐引擎等场景中表现出色。2024年4月,ISO批准了图查询语言GQL标准,Neo4j的Cypher查询语言完全符合该标准。现代工具提供拖拽式工作流程,GenAI可作为自然语言接口,将用户请求转换为Cypher查询。

ByteDance推出Mini-o3:让AI像人类侦探一样深度思考的视觉搜索突破

ByteDance团队开发的Mini-o3系统通过深度多轮推理突破了传统AI视觉理解的局限。该系统能像人类侦探般进行几十轮的视觉探索,在困难的视觉搜索任务上准确率达48%,相比现有模型提升显著。核心创新包括挑战性的Visual Probe数据集、多样化推理策略训练和突破性的过轮掩码技术,实现了测试时思考轮数的自然扩展。

OpenAI 和 NVIDIA 宣布达成合作,部署 10 吉瓦 NVIDIA 系统

是德科技:从芯片到智能网络,全面验证O-RAN无线连接

施耐德电气朱文沁:可靠电力是未来工业发展的“稳定器”

Facebook推出AI约会助手提升交友体验

Neo4j支持新图查询标准,助力AI时代数据访问

VAST Data收购Red Stapler获得公有云突发扩展能力

Google DeepMind升级前沿AI安全框架,防范操控和抗关停风险

新墨西哥州批准1650亿美元AI数据中心项目

橡树岭国家实验室测试量子超算集成技术

英伟达押注英特尔,CUDA护城河扩大,AI工厂重塑数据中心

OpenAI与英伟达千亿美元AI计划:能耗相当于10座核反应堆

DeepMind发布AI安全报告:警示"失调"AI的潜在威胁