解读Wikibon 2017年大数据分析预测报告

ZD至顶网软件频道消息:Wikibon最近完成了2017年大数据全球预测,该报告的作者是Wikibon分析师George Gilbert,以及Wikibon的Ralph Finos和Peter Burris,涉及到大数据的市场规模、增长和趋势等。

今年,我们把重点放在构建实现大数据成果所必需的战略业务能力来说最重要的大数据软件技术上。下面是该报告主要的一些研究发现:

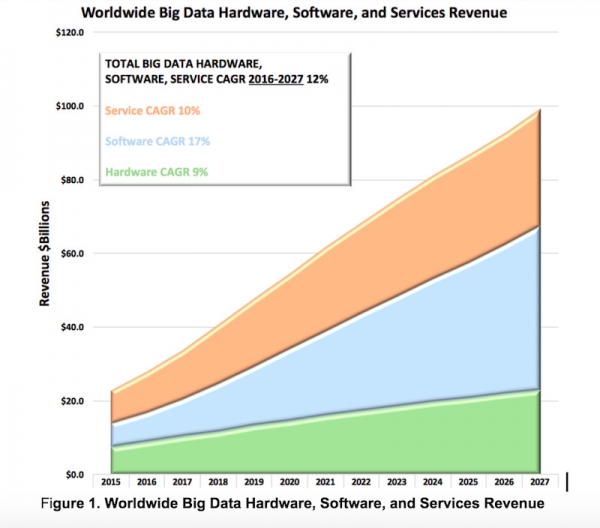

- 2016年,全球大数据硬件、软件和服务整体市场增长22%达到281亿美元,让大数据成为技术领域更具吸引力的领域之一。

- 我们的模型显示,到2027年期间,在大数据硬件、软件和服务上的整体开支的复合年增长率为12%,将达到大约970亿美元,而这主要是受到了大数据软件的推动。

- 不过,即使大数据仍然是企业关注热点,但是严重的问题也使得大数据市场出现了一些黯淡之处。特别是,大数据项目的故障率很高,甚至是信息技术标准。

- 大数据市场正在快速变革,以应对项目故障率较高的问题。正如我们所预测的,对基础设施的关注正在转移到对使用实例、应用、利用大数据能力创建可持续业务价值上来。

- 为了避免出现基础设施问题,企业对于把云用于大数据应用特别感兴趣。

大数据软件细分市场快速增长

与很多技术领域一样,大数据领域的很多项目首先是把焦点集中在了硬件和基础设施软件上。在大数据领域,获取、保存和处理大量大数据有很多需要的技术。因此,用户提到了大规模处理较高数据到达率而构建“数据湖”能力。这种能力仍然很重要,但是构建集群、数据库和数据迁移工具是不够的。如今,企业领导者重新将注意力集中在了构建大数据软件和系统的工具和业务能力上。下面就让我们来快速浏览一下每个大数据软件细分的趋势:

- 应用数据库增加了分析数据库的功能。越来越多的数据分析会实时地给人类和机器发送通知信息。2016年这个细分领域的总规模为26亿美元,到2020年增幅放缓到30%达到77亿美元。

- 分析数据库不止是数据湖。作为数据湖的主干,MPP SQL数据库将继续变革,最终成为大规模、高级、离线分析的平台。2016年这个细分领域的总体规模为25亿美元,增幅要慢于总体水平,到2020年达到38亿美元。

- 在线选择的增长是以大笔基础设施开支为代价的。这个部分包括像Spark、Splunk和AWS EMR这样的产品,2016年的总体规模为17亿美元。到2020年期间增幅抢眼,到2020年规模将达到61亿美元。

- 物联网应用将提升持续处理基础设施。这个细分领域将是新兴的、基于微服务的大数据应用的基础,包括大多数智能交互系统,在2016年的总体规模为2亿美元,但是到2020年将增长到18亿美元。

- 数据科学工具链正在演变为带有API的模型。今天,数据科学工具链要求有专门的专家来架构、管理和操作。但是,复杂的数据科学工具链——包括针对机器学习的——都将转变为实时的、预培训的模型,可通过开发者应用编程接口进行访问。这个细分领域的总体规模是2亿美元,到2020将达到18亿美元。

- 机器学习应用现在大多都是定制的。除了出现很多新的专业公司之外,这些应用还将在现有的企业应用中更为普及。2016年这个市场总体规模为9亿美元,到2020年它将赶超其他所有大数据细分市场,规模达到63亿美元。

行动项目:企业正在迅速积累大数据经验,但是还不够快,无法满足商业领袖的想象力和需求。2017年及之后,CIO们需要专注于战略业务能力,以更快速地创建、具有成本效益地管理、成功地集成高级分析系统。

好文章,需要你的鼓励

Allen AI团队推出SAGE:首个能像人类一样“想看多长就看多长“的智能视频分析系统

Allen AI研究所联合多家顶尖机构推出SAGE智能视频分析系统,首次实现类人化的"任意时长推理"能力。该系统能根据问题复杂程度灵活调整分析策略,配备六种智能工具进行协同分析,在处理10分钟以上视频时准确率提升8.2%。研究团队创建了包含1744个真实娱乐视频问题的SAGE-Bench评估平台,并采用创新的AI生成训练数据方法,为视频AI技术的实际应用开辟了新路径。

联想推出DE6600系列:更智能的存储解决方案

联想推出新一代NVMe存储解决方案DE6600系列,包含全闪存DE6600F和混合存储DE6600H两款型号。该系列产品延迟低于100微秒,支持多种连接协议,2U机架可容纳24块NVMe驱动器。容量可从367TB扩展至1.798PiB全闪存或7.741PiB混合配置,适用于AI、高性能计算、实时分析等场景,并配备双活控制器和XClarity统一管理平台。

AI视觉模型真的能看懂长篇文档吗?中科院团队首次揭开视觉文本压缩的真相

中科院团队首次系统评估了AI视觉模型在文本压缩环境下的理解能力,发现虽然AI能准确识别压缩图像中的文字,但在理解深层含义、建立关联推理方面表现不佳。研究通过VTCBench测试系统揭示了AI存在"位置偏差"等问题,为视觉文本压缩技术的改进指明方向。

Palo Alto Networks与谷歌云签署数十亿美元AI合作协议

OpenAI 获百亿美元融资与AI投资热潮持续升温

Meta计划2026年发布新一代图像视频AI模型

数字孪生联盟推出四个全新测试平台

BT:英国量子技术发展下一阶段取决于网络建设

Kodiak AI利用自动驾驶技术和物联网连接变革货运行业

Oracle和OpenAI数据中心项目获密歇根州监管机构批准

Optera室温光谱烧孔光学存储技术突破

英特尔助火山引擎“优化”AI云技术内核

数智时代,openGauss Summit 2025即将发布哪些技术创新破局

“算力+储能”深度融合:超智算发布分布式算力超级节点储能解决方案

联想推出DE6600系列:更智能的存储解决方案