押注人工智能:三大巨头谷歌、微软和亚马逊的战略分析

至顶网软件频道消息: Google刚刚宣布了对其机器学习服务(MLaaS)进行重大改进,以缩小过去一年中和微软之间的竞争差距。不仅如此, Amazon的AWS去年11月份在AWS Re:Invent上宣布了自己新的MLaaS工具和服务,试图让AI应用开发人员在AWS云上构建自己的智能应用。 如今MLaaS还处于起步阶段,但对于那些更倾向于将所有杂乱细节留给其他人的企业来说,MLaaS可能会成为一个占主导的人工智能平台,这些企业点击一下就可以租赁到人工智能服务。本文总结了每个公司的战略和策略,并试图确定谁是赢家和输家。

MLaaS:承诺和问题

机器学习是很难的,特别是深度学习这个复杂领域。深度神经网络是以数以百万计的数据样本进行训练的,通过使用大量NVIDIA GPU进行分析,以提取和识别各种功能和类别。这是“人工智能时代”的曙光,所以企业和政府机构当然在争先恐后地弄清楚他们需要做什么来避免错过“下一个大事件”。为了到达目的地(无论在哪里),他们必须决定投资哪些项目,聘请稀缺人才,购买大量的服务器和GPU,为监督学习任务提供数据,然后建立和优化自己的深度神经网络(DNN)。听起来很难?那么,MLaaS提供了一个更简单的选择:选择一个捷径,并使用预先训练的神经网络来处理由主要云服务提供商提供的图像、视频、语音和自然语言处理。为什么要花时间和金钱自己来训练一个神经网络,尤其是当你可以写一个基于云的应用、通过一个简单的API来访问一个预先训练好的网络?

Google、微软和AWS:不同的优势和方法

Google MLaaS

战略:Google利用自己在人工智能和深度学习方面的领先专长(Google内部拥有超过7000个人工智能项目,全球超过100万人工智能用户),为人工智能开发提供最先进的开发工具和最高性能的硬件平台。这完全是关于开发人员的,因为Google不拥有像微软这样的用户。

策略:

- 让TensorFlow成为人工智能硬件和软件之王。

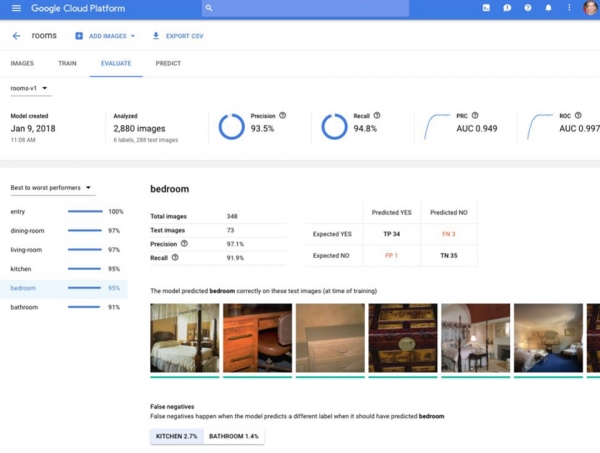

- 将人工智能应用于人工智能的开发。Google声称其最近宣布的Google Cloud AutoML可以极大地简化DNN开发的复杂任务。Cloud AutoML不是使用额外的自定义数据(如微软那样)来增强预先训练的API,而是从客户自己的数据开始,构建一个自定义深度学习模型。AutoML有非常酷的仪表板,你可以在开发和调整模型时轻松查看模型的效率。Google甚至将内部数据标记作为服务提供——这是一些人们认为最终将由人工智能实现自动化的手动过程。

- 将Google在数据中心之外的应用范围扩展到边缘消费者设备和自动驾驶汽车,获取Google云平台上的所有人工智能开发项目。

微软MLaaS

战略:使用微软庞大的企业和政府安装基础,以及其广泛的生产力和业务流程工具组合,成为企业中机器学习技术的默认提供商。

策略:

- 提供丰富的机器学习API来处理每种数据类型,因为每个公司或机构的数据都与其业务不同。使用户能够利用包含组织的产品、人员、词汇等的数据样本来扩展训练的神经网络(微软是第一个走上这条道路的公司,现在提供29个API,其中许多API支持DNN的定制训练数据)。

- 为那些需要构建自己的深度神经网络的客户提供最高性能的机器学习框架,尤其是针对自然语言处理的客户。

- 利用人工智能增强每个微软产品——为Office 365、Dynamics、Windows以及Redmond Vault中的每个产品提供智能功能。

亚马逊AWS MLaaS

战略:使用AWS的超大规模和丰富的工具集,为人工智能应用提供最具成本效益的开发和部署平台。

策略:

- 首先,将为亚马逊的大型在线业务开发的工具和平台提供为AWS服务。为Alexa和Amazon eComerce开发的工具,现在可以帮助你轻松构建聊天机器人或语音激活产品或服务。

- 提供世界级的开发工具,如MXNet框架、Lex、Rekognition和SageMaker,以减轻开发负担。这些工具都具有很高的粘性,确保AWS在开发过程完成后成为部署平台。 尤其是SageMaker很有趣,为整个机器学习开发生命周期提供了一个全方位管理的平台。

- 为每个开发人员提供最具成本效益的云基础架构,无论开发人员选择哪种CPU、GPU或AI Framework。

结论

首先,必须提醒的是:无论这些人工智能服务如何好,企业都需要认识到MLaaS的局限性。问题当然在于细节。如果预先训练好的网络作为一种服务不能充分地包含你想要识别的各种面孔、词汇和对象呢?如果你想在自己的基础设施上运行人工智能应用,将所有有价值的数据保存在内部(那么至少看起来数据是安全的)呢?在任何一种情况下,MLaaS都可能不是企业正在寻找的入口匝道。微软和谷歌正试图解决MLaaS的这些功能局限性,但我认为Google的方法可以产生更准确的结果——AutoML实际上是建立一个自定义的人工智能模型,而不是简单地提供一个可定制的预处理层。

顺便提一下,我很惊讶地发现AutoML是在NVIDIA GPU上运行的,而不是被称为GTP的Google TPU。我预计这种情况可能很快就会改变,但这确实表明,去年春天Google预先发布了Cloud TPU是为了颠覆NVIDIA GTC争取更多事件,而不是与即将到来的发布上市保持一致。

尽管如此,我相信Google在人工智能方面的实力将有助于Google达到并有可能超越微软目前在MLaaS技术上的领先地位,而微软在企业软件市场的实力将帮助其通过其应用组合实现其人工智能投资的变现。

来源:Forbes

好文章,需要你的鼓励

让AI记住房间每个角落:悉尼大学团队如何让视频生成拥有“空间记忆“

悉尼大学和微软研究院联合团队开发出名为Spatia的创新视频生成系统,通过维护3D点云"空间记忆"解决了AI视频生成中的长期一致性难题。该系统采用动静分离机制,将静态场景保存为持久记忆,同时生成动态内容,支持精确相机控制和交互式3D编辑,在多项基准测试中表现优异。

西班牙病毒如何将谷歌带到马拉加

33年后,贝尔纳多·金特罗决定寻找改变他人生的那个人——创造马拉加病毒的匿名程序员。这个相对无害的病毒激发了金特罗对网络安全的热情,促使他创立了VirusTotal公司,该公司于2012年被谷歌收购。这次收购将谷歌的欧洲网络安全中心带到了马拉加,使这座西班牙城市转变为科技中心。通过深入研究病毒代码和媒体寻人,金特罗最终发现病毒创造者是已故的安东尼奥·恩里克·阿斯托尔加。

马里兰大学突破性发现:AI推理过程终于有了“身体检查“——ThinkARM框架揭开大型语言模型思维奥秘

马里兰大学研究团队开发ThinkARM框架,首次系统分析AI推理过程。通过将思维分解为八种模式,发现AI存在三阶段推理节律,推理型与传统AI思维模式差异显著。研究揭示探索模式与正确性关联,不同效率优化方法对思维结构影响各异。这为AI系统诊断、改进提供新工具。

全国首批10城菁彩Vivid影厅启幕,《山河故人》重映见证影像新纪元

工业和信息化部人形机器人与具身智能标准化技术委员会成立大会暨第一次全体委员会议召开

生命科学计算测试专委会正式成立,BioProfile框架引领行业标准建设

超智算完成北京核心智算中心资产收购,加速构筑“3+X”全国算力网络新格局

走出“参数崇拜”:联想用“一体多端”重塑“人的尺度”

从“单点突破”到“一体多端”:拆解天禧AI 3.5进化背后三年的进化哲学

openGauss Summit 2025在京召开,加速行业智能化变革,共建繁荣数据库生态

2025联想天禧AI生态伙伴大会:天禧AI一体多端,与开发者共建个人AI生态

西班牙病毒如何将谷歌带到马拉加

LangChain核心库曝出严重漏洞,AI智能体机密信息面临泄露风险

Mill如何与亚马逊和全食超市达成合作协议

TechCrunch创业大赛中的9家顶尖生物技术初创公司