微软“创新杯”落地中国17载,成青年学子AI创业聚集地

2018年12月19日,2019微软“创新杯”全球学生科技大赛(以下简称“创新杯”)中国区总决赛在京举行。微软“创新杯”始于2003年,至今已连续成功举办了17届比赛。从全国838个参赛团队中过关斩将胜出的12支高校队伍,与各界投资和教育专家齐聚微软大厦。最终来自深圳大学的《轨道交通运营维保检测机器人》项目从12支决赛队伍中脱颖而出,夺得了微软“创新杯”中国赛区冠军。

深圳大学《轨道交通运营维保检测机器人》团队夺冠微软2019“创新杯”中国区总决赛

微软公司资深副总裁、大中华区董事长兼首席执行官柯睿杰(Alain Crozier)表示:“微软举办‘创新杯’的目的在于鼓励青年学生在微软最新技术平台创建前沿的科技解决方案,将创意变为商业现实。微软通过‘云暨移动技术孵化计划’、微软加速器等各种资源,为大学生开发者创新创业提供了全方位支持。17年来,大赛的参与者从开始的80后、90后,现在已经传承到00后,‘创新杯’正在逐渐成长为中国AI创新人才的培育基地,我们为‘创新杯’这些年在中国所取得的成就感到由衷的自豪。”

微软公司资深副总裁、大中华区董事长兼首席执行官柯睿杰现场致辞

2019微软“创新杯”中国区初赛中,来自全国18个省份201所高校的3486名学生共提交了838件作品,最终12支队伍经过层层角逐成功入围全国总决赛。本次比赛中75%的作品聚焦人工智能,运用视觉识别、大数据、机器学习等技术解决社会方方面面的挑战与难题。

此次冠军团队将目光聚焦在轨道交通检测领域。他们设计的地铁隧道铁轨检测机器人,通过机器视觉技术识别隧道内存在的故障,可以将地铁检测工人从繁重的体力劳动和恶劣的工作环境中解放出来,为日益增长的地铁运营提供一种高效、安全、低成本的解决方案。本次12支决赛参赛作品广泛涉及交通、医疗、农业、零售等多种行业,充分展示了当代青年学生的广阔视野和对社会问题与热点的关注。在人工智能技术开发上,微软一直强调“普及人工智能全民化”的理念,致力于把人工智能变成人人触手可及的生产力,解决人类面临的重大挑战。令人可喜的是,本次决赛中出现了很多这方面的作品,例如基于Azure的视障人群智能辅助耳机,为抑郁症患者开发的自我交流系统,针对突发事件人群设计的无人机搜救系统等,展示了技术造福人类的种种可能。

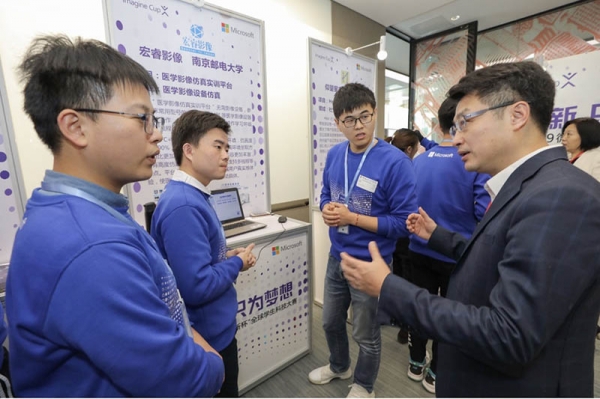

微软大中华区副总裁、公共服务事业部总经理滕文与参赛学生交流

赛后,微软还将为获奖团队提供专属导师群,由来自于微软研究院、微软解决方案部门、微软加速器和微软孵化器的导师组成,帮助他们进一步完善商业创意和落地。同时,微软创新生态将向优秀团队成员进一步开放,区域赛优胜队伍可以在当地与微软遍布全国的21个孵化器平台对接,获得实习机会、导师指导以及资源支持等后续扶植。微软希望通过进一步帮助参赛团队提升创新能力和将创新项目实现商业化的过程,使更多青年学子成为人工智能领域创新创业的主力军。

在过去17年里,有超过来自190个国家和地区的200多万名学生参与了全球“创新杯”比赛及相关活动。在中国,微软“创新杯”为超过23万名中国学生提供了孵化梦想的机会与平台。自2003年开始参加“创新杯”以来,中国学子在微软“创新杯”的国际舞台上屡创佳绩,共获得5项一等奖,9项二等奖,11项三等奖以及数次特别奖奖项。

未来,微软希望继续为青年学生和年轻创业者们提供充分释放创意和展示才华的平台,通过多样化的技术、工具和渠道予力AI创新人才,共同打造美好世界。

好文章,需要你的鼓励

UNIX V4磁带成功恢复:首个C语言编写的UNIX版本重新运行

计算机历史博物馆软件馆长Al Kossow成功恢复了上月在犹他大学发现的半世纪前磁带内容。UNIX V4是首个内核用C语言编写的UNIX操作系统版本,已从1970年代九轨磁带中成功恢复。现可从互联网档案馆下载并在SimH中运行。该版本包含约5.5万行代码,其中2.5万行为C语言,内核仅27KB大小。恢复过程使用了readtape程序采样原始磁通变化进行数据重建。

新加坡南洋理工大学提出“棱镜假设“:像光谱仪一样解读图像的神秘密码

新加坡南洋理工大学研究团队提出"棱镜假设",认为图像可像光谱一样分解为不同频率成分,低频承载语义信息,高频包含视觉细节。基于此开发的统一自编码系统UAE,通过频率域分解成功统一了图像理解和生成能力,在多项基准测试中超越现有方法,为构建真正统一的视觉AI系统提供了新思路,有望推动计算机视觉技术向更智能统一的方向发展。

AWS为Nutanix AHV虚拟化平台新增混合云存储支持

亚马逊云服务宣布其存储网关现已支持Nutanix的AHV虚拟化管理程序,进一步扩展混合云存储解决方案。此前AWS存储网关已支持VMware ESXi、微软Hyper-V和Linux KVM。由于AHV基于KVM架构,AWS表示添加支持相对容易。随着Broadcom收购VMware后策略调整,许多企业正寻求替代方案,Nutanix成为热门选择。分析师预测VMware可能在三年内失去35%的工作负载。

当AI遇到“健忘症“:芝加哥大学团队如何让智能助手不再胡编乱造

芝加哥伊利诺伊大学团队提出QuCo-RAG技术,通过检查AI训练数据统计信息而非内部信号来检测AI回答可靠性。该方法采用两阶段验证:预检查问题实体频率,运行时验证事实关联。实验显示准确率提升5-14个百分点,在多个模型上表现稳定,为AI可靠性检测提供了客观可验证的新方案。