机器能模拟人类感受?明略科技多模态团队斩获ACMMM全球顶会“最佳论文提名”

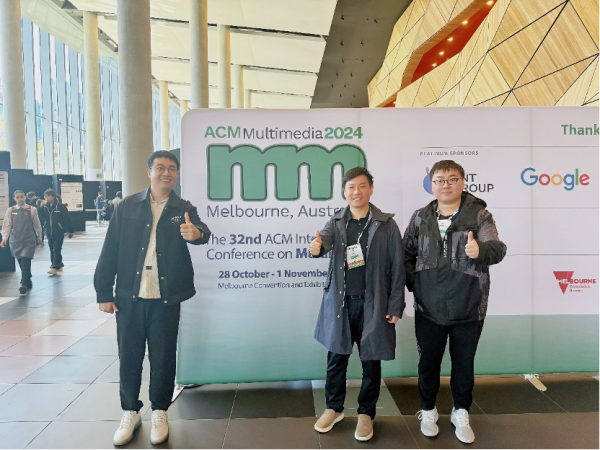

10月28日~11月1日,全球顶级多媒体会议ACM Multimedia(ACMMM)2024 在澳大利亚墨尔本成功召开。

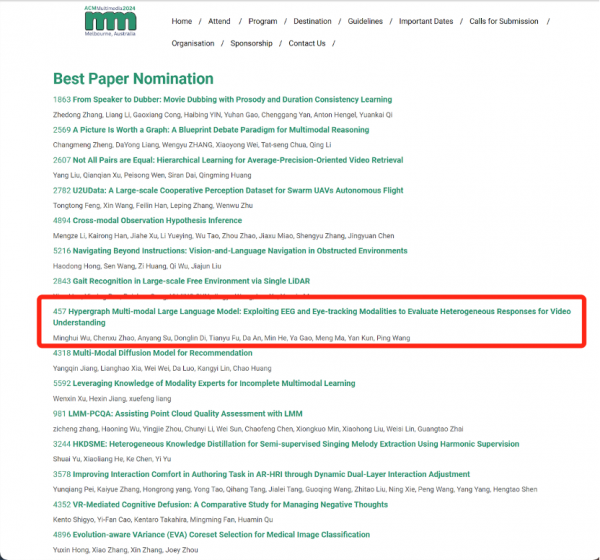

明略科技集团多模态团队与北京大学共同完成的最新研究成果《Hypergraph Multi-modal Large Language Model: Exploiting EEG and Eye-tracking Modalities to Evaluate Heterogeneous Responses for Video Understanding》在众多论文中脱颖而出,荣获最佳论文提名(Best paper nomination)。明略科技集团创始人、董事长兼CEO吴明辉,多模态大模型部门负责人赵晨旭,明敬算法负责人苏安炀受邀赴墨尔本出席此次会议。

据悉,本次会议共收到4385篇有效投稿,其中,1149篇论文被接收,174篇论文被评选为Oral,最终仅26篇获得最佳论文提名。

明略科技集团创始人、董事长、CEO兼CTO吴明辉

在 ACMMM Oral Session 讲解最新研究成果

明略科技集团多模态团队在 ACMMM 2024 会议现场

(左起:苏安炀、吴明辉、赵晨旭)

ACMMM会议是由国际计算机学会(ACM)主办的多媒体领域的顶级国际学术会议,同时也是中国计算机学会推荐的A类国际学术会议(CCF-A)。自1993年举办以来,今年是第32届。会议议题涵盖多媒体计算的各个方面,如多媒体内容分析、多媒体检索、多媒体安全、人机交互、计算机视觉等。

ACMMM 2024 会议现场公布最佳论文提名奖项

针对当前AI领域在视频内容理解方面主要聚焦于客观层面,缺少主观层面的测量标准,以及机器模拟人类主观感受的有效手段的发展情况,明略科技的最新研究成果整合脑电、眼动信号等多种非标模态,构建了全新的多模态大语言模型范式,在机器理解和模拟人类主观感受的研究方向,迈出了重要一步。

明略科技多模态团队论文荣获 ACMMM 2024 最佳论文提名奖项

论文题目:Hypergraph Multi-modal Large Language Model: Exploiting EEG and Eye-tracking Modalities to Evaluate Heterogeneous Responses for Video Understanding

(超图多模态大语言模型:应用脑电和眼动模态来评估异质人群观看视频时的响应)

作者:吴明辉*,赵晨旭*,苏安炀*,狄东林,傅天宇,安达,何敏,高雅,马萌,颜鲲,王平(*为共同第一作者)

论文摘要:对视频创意和内容的理解往往因人而异,不同年龄、职业和性别的人的关注点和认知水平也存在差异。目前缺乏这方面的研究,没有可以进行评测的基础,大多数现有的基准都存在几个缺点:

1)模态数量有限,题目多为选择题,难以测量逻辑推理过程;

2)视频中的内容和场景过于单调,仅涉及到对视频内容的客观描述。

为了弥合与实际应用的差距,明略科技引入大规模的视频主观多模态评估数据集Video-SME。通过收集不同人群在观看相同视频内容时脑电图 (EEG) 和眼动追踪区域的真实变化,设立了新的任务和协议,分析和评估不同受试者对相同视频内容的认知理解程度。

依托新的评测标准,明略科技创新研发了超图多模态大语言模型 (HMLLM),探索不同人口统计、视频元素、脑电图和眼动追踪指标之间的关联。HMLLM可以弥合丰富模态之间的语义差距,并集成帧与帧之间的信息以执行逻辑推理。明略科技在Video-SME和其他基于视频的生成性能基准上设计了实验,大量实验评估证明了该方法的有效性。

什么是人的主观感受?

测量不同人群观看广告视频的主观响应有何意义?

人在观看广告视频时,对于素材元素的认知程度、情绪高低、眼睛注视程度高低都是人的主观感受,不同性别、年龄、职业、身份的人群都会有所不同。

如果机器能够模拟不同人群观看广告视频时的不同主观感受,那么相当于可以对广告视频的内容、创意等进行有效的测量,指导广告成片过程,节省广告投放成本。

让机器学习、理解和模拟人类的主观感受,可能是赋予机器主观意识的开端。明略科技提出的新基准Video-SME有望成为该领域的新起点,标志着机器对视频的理解从客观维度向主观维度的转变。作为一种全新的范式,明略科技多模态大模型HMLLM的研发,致力于为该领域研究人员解决非标准模态问题提供宝贵经验与启示,从而促进大模型领域向人机协同的美好未来迈进。

本研究课题由科技部科技创新2030——“新一代人工智能(2030)”重大项目支持。

论文链接:

https://dl.acm.org/doi/10.1145/3664647.3680810

GitHub地址:

GitHub - mininglamp-MLLM/HMLLM: [ACM MM2024] The code for HMLLM.

来源:至顶网软件与服务频道

好文章,需要你的鼓励

AI投资有望在2026年获得真正回报的原因解析

尽管全球企业AI投资在2024年达到2523亿美元,但MIT研究显示95%的企业仍未从生成式AI投资中获得回报。专家预测2026年将成为转折点,企业将从试点阶段转向实际部署。关键在于CEO精准识别高影响领域,推进AI代理技术应用,并加强员工AI能力培训。Forrester预测30%大型企业将实施强制AI培训,而Gartner预计到2028年15%日常工作决策将由AI自主完成。

北大学者革新软件诊断方式:让代码问题的“病因“无处遁形

这项由北京大学等机构联合完成的研究,开发了名为GraphLocator的智能软件问题诊断系统,通过构建代码依赖图和因果问题图,能够像医生诊断疾病一样精确定位软件问题的根源。在三个大型数据集的测试中,该系统比现有方法平均提高了19.49%的召回率和11.89%的精确率,特别在处理复杂的跨模块问题时表现优异,为软件维护效率的提升开辟了新路径。

2026年软件定价大洗牌:IT领导者必须知道的关键变化

2026年软件行业将迎来定价模式的根本性变革,从传统按席位收费转向基于结果的付费模式。AI正在重塑整个软件经济学,企业IT预算的12-15%已投入AI领域。这一转变要求建立明确的成功衡量指标,如Zendesk以"自动化解决方案"为标准。未来将出现更精简的工程团队,80%的工程师需要为AI驱动的角色提升技能,同时需要重新设计软件开发和部署流程以适应AI优先的工作流程。

德国达姆施塔特工业大学团队首次揭秘:专家混合模型AI的“安全开关“竟然如此脆弱

这项由德国达姆施塔特工业大学领导的国际研究团队首次发现,当前最先进的专家混合模型AI系统存在严重安全漏洞。通过开发GateBreaker攻击框架,研究人员证明仅需关闭约3%的特定神经元,就能让AI的攻击成功率从7.4%暴增至64.9%。该研究揭示了专家混合模型安全机制过度集中的根本缺陷,为AI安全领域敲响了警钟。

稚晖君发布全球最小全身力控人形机器人,上纬启元开启个人机器人时代

2026年软件定价大洗牌:IT领导者必须知道的关键变化

Linux 在 2026 年将势不可挡,但一个开源传奇可能难以为继

CES 2026趋势展望:全球最大科技展五大热门话题预测

人工智能时代为何编程技能比以往更重要

AI颠覆云优先战略:混合计算成为唯一出路

谷歌发布JAX-Privacy 1.0:大规模差分隐私机器学习工具库

谷歌量子AI发布新型优化算法DQI:量子计算优化领域的重大突破

缓解电动汽车里程焦虑:简单AI模型如何预测充电桩可用性

Titans + MIRAS:让AI拥有长期记忆能力

Gemini为STOC 2026大会理论计算机科学家提供自动化反馈

夸克AI眼镜持续升级:首次OTA,支持89种语言翻译

机器能模拟人类感受?明略科技多模态团队斩获ACMMM全球顶会“最佳论文提名”

生成式AI、微短剧、情绪营销......如何挖掘下一个流量机会?这里有套方法论

明略科技吴明辉:企业迎接大模型时代,要解决知识工程问题

明略科技集团推出小明助理Copilot,以AI驱动知识管理

明略科技集团旗下明略智通推出O2O精准派样解决方案

95%员工用上大模型,明略科技想让更多企业拿到大模型船票

2023第七届营销科学大会揭示大模型时代营销的广阔“可为”前景

2023第七届营销科学大会揭示大模型时代营销的广阔“可为”前景

2023第七届营销科学大会即将拉开帷幕,开启未来营销科技新纪元

跨越AI 1.0到2.0,明略科技营销大模型赛道下的创新与发展