从读图到懂图,AI+金融理解力新升级 原创

客户电话记录、合同、社交媒体互动、电子邮件……金融机构每天都会生成海量的数据,非结构化数据就占了其中的九成,而图片又是最难啃的一块。

过去,OCR(光学字符识别)凭借将图像转为可编辑文字的能力,长期承担着金融行业的“识字官”角色,在身份验证、风险管理、合规审查等环节等环节都发挥着关键作用。

然而这个已有百年历史的OCR,最近也有“要落伍”的声音。一边是业务场景日趋复杂,一边是生成式AI的全面崛起。多模态大模型凭借端到端的图像识别与语义理解能力,正在颠覆传统OCR的应用逻辑,也预示着图像识别与理解正迈向新一代的技术范式。

四个维度对比下来,大模型简直太香了

金融业务中,图像处理的复杂性和压力正持续攀升。以银行网点为例,客户在办理业务时需要填写各类票据,柜台人员再将其扫描为电子版传至后台处理。这类票据版式复杂、信息密集,还常包含手写签名,处理难度极高。跨境金融业务则更具挑战性,不同国家的单据标准各异,同一种单据有的叫“装箱单”,有的叫“装箱单/重量证明”,格式和称谓的差异,为处理带来额外障碍。

不仅是银行,保险和证券等领域同样面临类似挑战。例如,投研与投教场景中涉及大量图表与表格识别,保险的核保与理赔流程中,客户上传的大量非结构化图像类数据,也需要智能化识别理解后处理。

曾经作为数字化处理核心工具的OCR,如今在面对业务量激增、格式多样、逻辑复杂的文档时,局限性逐渐暴露。

具体来说,传统OCR技术面临多种挑战:对图像清晰度和排版高度依赖,难以处理复杂背景和手写文本,对多语言或特殊字符的支持不足,更缺乏对上下文与图像和语义的理解。结果是,OCR能自动识别文字,但无法理解其业务语义和逻辑关系,导致人工仍需大量介入进行校对、整理和分析。

正因如此,金融行业开始探索更先进的技术方案,以突破传统OCR的局限。随着语言模型在金融领域的广泛应用,行业也开始尝试将视觉模型引入实际业务场景。从四个关键维度来看,以Qwen-VL为代表的视觉理解大模型可以对传统技术手段带来增强:

第一,泛化能力。OCR高度依赖预设模板,对零样本或少样本任务适应性差,难以处理格式多变的文档。大模型则具备更强的视觉推理与指令遵循能力,在复杂任务中展现出明显优势。

第二,语义与版面理解。OCR只能“识字”,却无法理解业务语义,往往需要额外模块来整合信息,拓展性有限。大模型通过大规模图文训练,不仅能结合图像布局、上下文和常识进行识别与推理,还能在未见过的场景中保持较高准确度。

第三,鲁棒性。OCR对旋转、反光、污损或倾斜等现实干扰极为敏感,准确率容易下降。大模型则能同时识别文字并理解语义,以端到端的方式完成原本复杂的NLP任务,实现真正的业务信息理解。

第四,上下文推理。OCR难以进行跨图片关联分析和逻辑判断,对业务上下文理解不足。大模型的视觉编码器经过复杂场景训练,即使面对模糊、遮挡或低光照环境,也能稳健提取特征,显著提升在真实业务场景中的可靠性。

相比之下,大模型简直太香了!在同一维度上展现出明显优势,为金融行业图像识别理解提供了全新的智能化路径,也预示着文档处理从“识字”向“理解”与“推理”升级的趋势正在加速。

复杂图像处理,我们有四条攻略路径

在最新一期《AI友妙计——金融行业Agent百景图-模力时刻》直播中,演示了“VL多模态Agent的构建全流程”,展示了Qwen-VL-Max如何结合图像布局、视觉上下文与常识推理,实现对图片的深度理解与语义解析。

这些能力并非孤立存在,而是深度嵌入大模型落地的整体流程中。在金融机构的实际应用中,针对不同场景任务要求及复杂程度,通常通过四种使用范式得以体现。

范式一:简单Prompt+VL,直接问图要答案。

1、“同一对象不同名称”问题在跨境电商中非常明显,例如,装箱单版式并不统一,传统方法难以直接适应,而大模型凭借其强大的泛化能力,可以通篇理解文档内容,从而准确提取所需信息,而不局限于固定字符或模板。

在实际操作中,只需给Qwen-VL-Max一个简单提示:你是文字识别高手,请识别图像中的单据名称,并以markdown格式输出。在这一指令下,大模型不仅能准确识别标准格式的装箱单,也能处理版式完全不同的单据,仍然输出正确的“Packing List”。

对于大量图片场景,这种方法尤其实用。相比为每张图片单独训练专有模型,大模型可以利用其泛化能力,直接处理多样化图像,通常即可达到八九成的准确率,有效实现原本难以结构化的文档内容的自动化提取。

2、“不同版面的数据提取”也是一大重点需求,保险机构有着大量个人体验报告,但每家机构的报告格式都不尽相同,测试时给Qwen-VL-Max的指令依然很简单:你是一个文字识别高手,擅长根据用户的要求提取图片中的姓名、身高、体重、左右眼视力,并使用json格式输出。模型就能够按照指令准确提取出每张图片中的关键信息。

而且模型还能展示解析过程。例如,说明如何在姓名栏找到“某某”,在身高栏定位到“172”,并标注对应的大类信息。这种可追溯的输出不仅方便检查,也让处理结果更可靠,尤其适合对数据透明度和可解释性有要求的场景。

3、“不同格式的识别与理解”对技术人员是一大困扰,不同单据上日期格式各异,有的写成 YYYYMMDD,有的写成MMDDYYYY,面对这种差异,大模型可以识别并统一输出。

通过提示词,可以让模型提取图片中的日期,并将其统一转化为“年月日”格式。在更复杂的场景中,一张单据可能包含多个日期,例如发货日期和到达日期。这时可以指定只提取“发货日期”,模型便能基于语义理解,从对应字段中准确定位并提取所需日期,同时输出中既包含统一格式,也保留原始格式,便于后续校对。

表面上看似简单的任务,实际上会要求模型先理解图片、识别文字,再执行具体指令。Qwen-VL-Max继承了大语言模型的基础能力,包括语法、语义、上下文关系乃至逻辑推理,因此它不仅能“看见”,还能“看懂”,实现视觉信息与语言信息的深度融合,完成真正的图文理解。

4、“公司信息提取”是一个基础的不能在基础的工作,因为名称、地址和联系方式,这些信息在后续的单据审核中至关重要。通过提示词:提取图片中的公司名称、地址、联系方式,并以json格式输出。Qwen-VL-Max识别出了“阿里云”,但却将淘宝的联系信息错误地归入阿里云,造成了公司实体的混淆。为解决这一问题,只需在提示词中增加明确约束:要求区分不同公司实体,避免信息混淆。

调整后,输出结构明显改善,卖方被正确标注为阿里云,买方为淘宝,并且对应联系信息被正确归类。模型还能提供详细的解析说明,这种可解释性在处理单据时非常有用,尤其是面对容易混淆的字段。可以把模型理解为一个有经验的助手,它会根据提示完成关键提取,并在必要时提供提醒,就像人类在工作中也会标注需要注意的地方一样。

5、“不符点审核”是单据审核中较为复杂的任务。在演示中,单据中部的“for account”一栏用于说明货运过程中的风险承担方,而底部的承运条款则需要核实条款内容,需要核实不同栏位的信息是否一致。

Qwen-VL-Max根据提示词步骤完成审核:先检查条款,找到条款内容;再提取费用和风险承担方信息,识别出“for account”栏的买方承担责任;最后对比条款要求与列明的承担方,判断信息是否一致。

凭借对条款语义的理解,例如“卖方运输完成交货后风险转移至买方”,Qwen-VL-Max能够正确得出条款信息与承担方一致的结论,审核通过。这一过程展示了其在复杂单据中处理多种信息、进行关联性审核的能力。

6、“图像提取”对于信息量大、结构复杂的研报而言就是最佳场景,研报中有折线图、柱状图以及各类数字指标,使用研报时往往需要对这些信息进行提取和结构化处理。根据提示词,Qwen-VL-Max能够准确将集团各业务收入占比提取出来,并生成清晰的表格,同时对各板块进行简单总结,实现“所见即所得”的结构化提取,大幅降低人工整理成本。

同时Qwen-VL-Max还能够理解研报内容并进行必要分析,无论是以表格形式输出,还是以推理形式总结,只要明确指令,模型都能按照需求生成结构化结果。

7、“空间理解”是Qwen-VL-Max一个重要能力,在真实业务中,拍照角度、旋转、倾斜、打印压线甚至制服重叠等情况,这些都会干扰模型的识别。对一张倒置的户口卡进行测试,Qwen-VL-Max能够准确理解图像内容,识别出正确的“迁户日期”,展现出了高适配性。

8、“字符重叠”是单据处理中常见的情况。例如在演示中,“Port of Landing”一栏的港口信息“HUANGPU”与其他栏位内容直接重叠。肉眼观察可能需要仔细辨认,但现在只需直接向模型提问,如“提取图片中Port of Landing的信息”,就能准确得到答案,不受重叠内容干扰。即使信息部分被覆盖或叠加,Qwen-VL-Max依然能够识别覆盖与被覆盖的内容,并理解这些不同表达方式指向同一信息类型。

9、“信息缺失”在打印或其他场景中频出,Qwen-VL-Max能够通过推理进行补全。演示中,“最终目的地”栏本应显示“Hong Kong”,但打印时最后两个字被截掉,仅显示“KO”。只需询问“货运目的地是哪里?”,模型即可自动补全缺失信息,准确输出“Hong Kong”。

Qwen-VL-Max的视觉编码器经过大量复杂场景训练,包括模糊、遮挡、低光照、压线、重叠等情况,使其在干扰条件下依然能够准确识别和理解信息。无论是图片翻转、文字覆盖、制服重叠,还是压线、水印等特殊情况,模型都能保持稳定的识别效果。

范式二:复杂Prompt调优+VL,约束与示例提升效果。

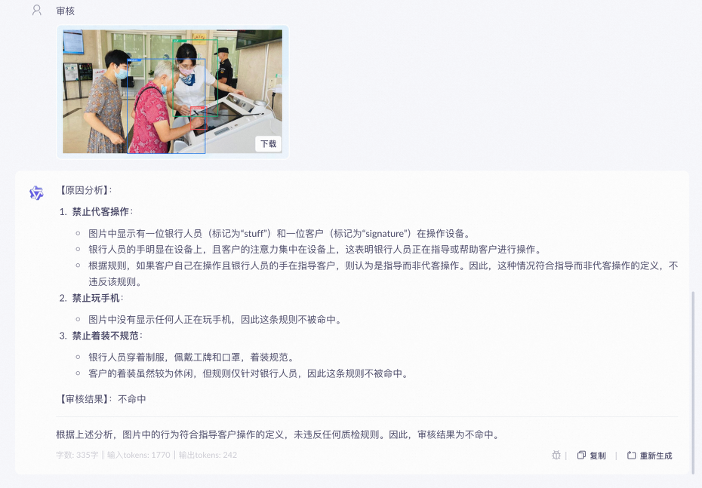

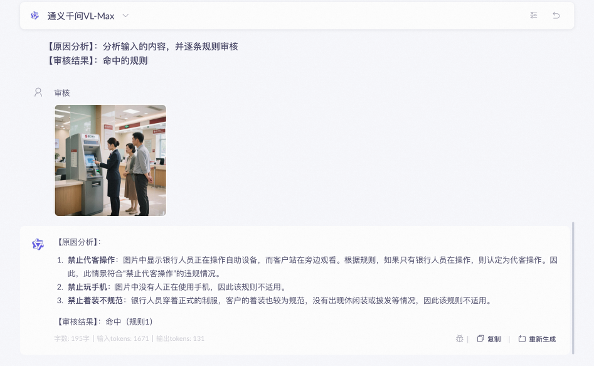

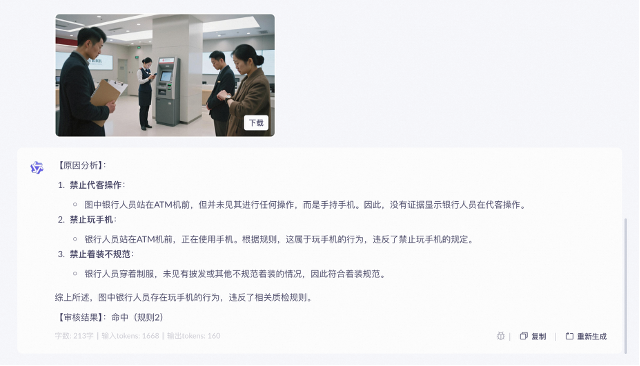

1、“认知现实物体”有别于识别文档,演示中展示了,模型能够分辨业务人员是在引导客户使用自助设备,而非代替客户操作。提示词首先要明确审核原则,界定行为范围,确保只检查违规操作;其次设定输出规则,命中即违规,不命中即合规;最后定义质检要求,包括禁止代客操作、禁止玩手机、着装规范等。虽然规则看起来复杂,但在实际工作中,这些都是银行审核流程的一部分。一旦模型掌握规则,将图片输入后即可完成自动审核,大大节省人工检查时间。

最终,Qwen-VL-Max判断图片中符合规则的指导行为,并同时验证了其他检查点,如未违规使用手机、着装规范等,实现了完整、准确的合规审核。即使图片中有多个人员,模型也会严格遵循审核原则,进行识别。

通过对两张违规操作图片的识别,Qwen-VL-Max分析后显示:在第一张图片中,银行人员正在操作设备,而客户仅在旁观看,根据规则判定为“禁止代课操作”的违规行为。其他检查项如玩手机、着装不规范未命中,因此最终输出为命中违规规则。另一张图片中,识别到银行人员在使用手机,命中“禁止玩手机”规则。可见模型不仅能识别文字,还能理解图像内容与场景,从而执行复杂的行为规范审核。

同时也体现出提示词设计的重要性,银行本身已有一套行为规范清单,只需将这些操作规范列出作为模型的审核规则,并明确模型角色和任务,模型就能按照要求完成分析并输出准确结果。

2、“多图推理”可以同时输入多张图片,结合信息进行统一分析,最终给出综合结果。演示通过工作流来实现多图处理,工作流中“开始”对应输入内容,“结束”对应模型输出结果,中间嵌入VL模型节点,将图片传入模型。同时附上简单提示:你是研报信息提取高手;擅长从研报中提取表格数据,并以表格形式输出。

当表格被截断时,其剩余内容出现在第二页的另一张图片中。通过直接让Qwen-VL-Max模型提取“表六”中的阿里巴巴营收预测数据,并生成一个新的完整表格。结果显示,模型合并了第二张图片的“云智能集团”的营收与同比增长数据、“大文娱”和“其他业务”部分,最终拼接成一份完整的表格。对于跨图、跨页的表格场景,这种方式非常实用,特别是在处理研报或各类复杂文档时。

3、“视频审核”是图像审核的进阶,也更为复杂。在视频审核中,通常需要关注两个方面:一是口播文本是否合规,例如宣传内容是否违规;二是画面是否合规,如人物形象、场景元素是否触碰规则。

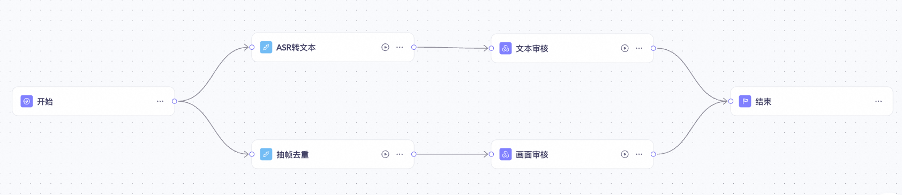

需要构建两个工作流:一个对语音转文本内容进行审核,一个对视频画面内容进行审核。

根据视频内容,无论画面还是文本,都未触发任何规则,最终判定为合规。值得一提的是,若后续有新规出台,只需在提示词中更新规则,模型即可快速适配。

这说明Qwen-VL-Max不仅能理解画面与语音内容,还能结合语义进行判断,适应不断更新的审核要求。类似的能力在金融场景中有多种应用。例如在银行领域,视频巡检可结合人员动作和语音,判断是否存在“代客操作”。在保险领域,可通过视频对照护理手册,检查护工是否按标准执行喂食、洗护等操作。在证券领域,则能用于投教视频合规性审核,检测讲解内容和画面规范性。

通过构建合适的工作流,并结合模型的多模态理解能力,能让审核流程变得更加高效、准确,成为提升合规和运营效率的重要“帮手”。

范式一和范式二主要通过简单或复杂的提示词调优,让Qwen-VL-Max模型在特定领域发挥更佳效果。但在实际业务中,仅靠这种方式并不足以覆盖所有问题,这就需要引入范式三和范式四。

范式三:VL指令微调,精准任务专训。

在某些高度专业的领域,往往涉及模型在训练阶段几乎未曾接触过的专有知识,这时就需要通过“后训练”来补充。

还有一类情况则是“复杂任务”,这类任务通常不同于日常订酒店、订机票等业务的简单逻辑,往往要求高、步骤多,甚至带有金融等特殊属性。在这种情况下,需要构建相应的多步执行语料,让Qwen-VL-Max模型在特定数据下学会完成这些特殊任务。

范式四:Dianjin-Fin-OCR,看图说话+Grounding能力合成思维数据链。

尝试将Qwen-VL-Max大模型与专业小模型进行融合,发挥各自优势。训练逻辑也较为直观:首先,Qwen-VL-Max大模型对复杂图像进行初步识别,生成初始结果;接着调用外部工具“专业小模型”,获取对应结果;最后,将大模型初识别结果与外部工具结果一并输入Dianjin-Fin-OCR,其综合这些信息、重新推理,进而输出更准确的结果。

这个过程中,大模型不仅依赖自身能力,还参考了小模型提供的参考信息,形成类似“再思考(rethink)”的机制。

以印章识别为例:Dianjin-Fin-OCR模型通过初步识别、调用印章专有工具、再进行rethink,能够综合分析多方结果,最终准确输出印章内容,实现大模型与专业小模型的协同效应。

全能组合拳,视觉与逻辑的协同探索

Qwen-VL-Max展现了在图像理解、语义解析和业务逻辑推理上的综合能力。相比之前的增强版,它进一步提升了视觉推理能力和指令遵循能力,提供更高水平的视觉感知和认知能力,在更复杂的任务场景中表现出色。

VL模型的能力象限很宽,从目前实践来看,VL模型的能力象限很宽,从目前实践来看,Qwen-VL-Max的四大核心特性值得关注:第一,OCR增强:在特定场景和版面上显著提升文本识别效果;第二,Grounding能力:通过生成bounding boxes或points,模型能够准确定位图像对象,并以稳定的JSON格式输出坐标和属性信息;第三,认知现实物体:无论是地标、日常食物、动植物、汽车,还是商品标签识别,准确率均大幅提升;第四,文本理解能力:不仅能精准识别文档中的文字,还能提取文档元素(如图片、表格等)的位置信息,实现真正的“图文理解”。

如果直接使用VL无法满足特定场景下的任务要求,如果直接使用VL无法满足特定场景下的任务要求,Qwen-VL-Max既支持常规的图文数据微调,也探索创新方法,将大小模型生成的语料构建成推理思维链,用于Qwen-VL-Max训练。在发挥自身泛化与推理能力的同时,结合已有专有小模型的优势,实现协同增强,从而提升整体性能,实现1+1大于2的效果。

为便于企业部署,阿里云在公共云上,部署了商业版和开源版两类VL模型,可以通过通义点金和百炼平台调用。另外,在开源社区也提供了多种尺寸的VL模型,方便企业和个人开发者下载部署使用。用户可根据自身场景需求和算力资源,选择合适模型快速启动应用。

总结而言,OCR能做,Qwen-VL效果更好;OCR训练成本高,Qwen-VL零样本;OCR做不了,Qwen-VL同样可以胜任。

阿里云将于9月25日云栖大会期间举办 “新模力·新点金——金融大模型技术峰会”。峰会将聚焦全球化金融机构的云+AI之路,分享金融大模型从 “试水”到规模化应用的实践经验,以及头部金融机构在模型工程建设上的深度思考,展现金融大模型的应用潜力与行业化趋势。

扫码报名,洞察智能金融未来

扫码抢先体验“通义点金”平台

好文章,需要你的鼓励

Queen‘s大学重磅研究:程序员的角色即将彻底改变,从码农到智能体指挥官

Queen's大学研究团队提出结构化智能体软件工程框架SASE,重新定义人机协作模式。该框架将程序员角色从代码编写者转变为AI团队指挥者,建立双向咨询机制和标准化文档系统,解决AI编程中的质量控制难题,为软件工程向智能化协作时代转型提供系统性解决方案。

苹果发布 iOS 26.0.1 系统更新,修复多项关键问题

苹果在iOS 26公开发布两周后推出首个修复更新iOS 26.0.1,建议所有用户安装。由于重大版本发布通常伴随漏洞,许多用户此前选择安装iOS 18.7。尽管iOS 26经过数月测试,但更大用户基数能发现更多问题。新版本与iPhone 17等新机型同期发布,测试范围此前受限。预计苹果将继续发布后续修复版本。

医疗AI的“显微镜革命“:西北工业大学团队发布首个超声影像专用智能助手EchoVLM

西北工业大学与中山大学合作开发了首个超声专用AI视觉语言模型EchoVLM,通过收集15家医院20万病例和147万超声图像,采用专家混合架构,实现了比通用AI模型准确率提升10分以上的突破。该系统能自动生成超声报告、进行诊断分析和回答专业问题,为医生提供智能辅助,推动医疗AI向专业化发展。

业界首款符合AEC-Q200标准额定电压高达1,000 VDC高压保险丝

数据中心的智算挑战,英特尔要如何应对?

下一代智能工厂怎么建?开放自动化给出“解题思路”

跟随西门子,在工博会感受沉浸式的工业AI体验

苹果发布 iOS 26.0.1 系统更新,修复多项关键问题

OpenAI将发布类似TikTok的社交应用,搭配Sora 2视频模型

微软推出Office智能体模式让用户"氛围办公"

AI助手现在能帮你创建高质量Word文档和Excel表格

高通新一代骁龙平台将推动智能体AI时代到来

SAPx阿里云,开启一条通往中国市场与全球化发展的全新路径

微软推出"氛围工作"模式,为Office套件加入AI智能体

OpenAI推出智能购物系统挑战谷歌亚马逊

用友的AI方法论,是帮企业搞定上下文工程?

为什么AI总画不出你想要的画?NextStep-1让AI生图实现“所思即所得”

钉钉十年,无招终于等来了AI这把“锤子”

百炼成金 向AI炼成金融能力

名企齐聚!阿里云携手牧原、UU跑腿、新开普等豫企共绘数智未来

对话后摩智能吴强:大模型90%计算需求将来自端边,存算一体是未来

阶跃星辰发布三代基础大模型、成立生态联盟,并提出了模型的“好用标准”

学霸还是学渣,数学能力训练到底提升了什么?深度揭秘大模型能力迁移的秘密

调研了300家企业,ICONIQ 发布《开发者手册:2025年AI现状报告》,揭秘企业AI落地的全景路线

里通义开源音频生成模型,能模仿音效师为视频配音