微软推出“实时人工智能”平台 将使Azure变为“人工智能云” 原创

8月22日,微软再次推出其针对实时人工智能的Brainwave深度学习加速平台。而微软正在逐步曝光其将深度学习平台带入可定制芯片的计划和细节,这将使Azure成为“人工智能云”。

微软至少在2016年就曾经好几次谈过Brainwave。这一次,Brainwave的推出出现在本周的Hot Chips 2017大会上。

Brainwave由高性能分布式系统架构构成,运行在被称为现场可编程阵列(FPGA)的可定制芯片上的硬件深层神经网络引擎之上,微软今天在Research博客文章中表示,其中还包括一个用于部署在受过训练的模型编译器。

如同个月在博客文章中提到的,根据微软在2016年推出的可配置云计划,Brainwave是运行在基于FPGA硬件微服务的深度学习平台。演示提到了数据中心或互联网上的“硬件加速即服务”(Hardware Acceleration as a Service)。Brainwave分布式神经网络模型可以按照需要跨越多个FPGA。

此外,微软计划七月份在公司最近于雷德蒙德举办的Faculty Research Summit上讨论Brainwave,但是最终改变了主意。

在Hot Chips 2017大会上,微软的官员们表示,使用英特尔新的Stratix-10芯片,Brainwave在没有批处理的情况下实现了39.5兆次运算的持续性能。微软认为:Brainwave将使Azure用户能够在这种级别的性能下运行复杂的深度学习模型。

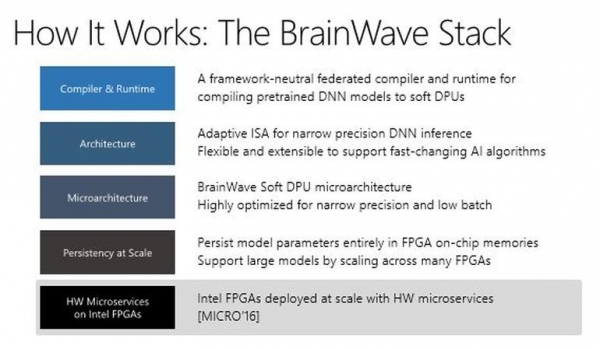

这是微软在Hot Chips大会上演示文稿中的新架构图,它显示了Brainwave的组件:

微软正在寻求在硬件微服务器上运行的Brainwave,推动受到部署在云端人工智能影响的服务边界,包括计算机视觉、自然语言处理和语音。

微软表示,他们将在2018年内通过Azure为外部开发人员提供FPGA。而微软并不是唯一一家在自己的云数据中心期待FPGA的公司,目前亚马逊和谷歌都在使用定制硅完成人工智能任务。

好文章,需要你的鼓励

全球数据中心电力需求暴涨,超越电网建设速度

国际能源署发布的2025年世界能源展望报告显示,全球AI竞赛推动创纪录的石油、天然气、煤炭和核能消耗,加剧地缘政治紧张局势和气候危机。数据中心用电量预计到2035年将增长三倍,全球数据中心投资预计2025年达5800亿美元,超过全球石油供应投资的5400亿美元。报告呼吁采取新方法实现2050年净零排放目标。

维吉尼亚理工学院破解单细胞生物学新密码:当大语言模型遇见细胞世界的奇妙变革

维吉尼亚理工学院研究团队对58个大语言模型在单细胞生物学领域的应用进行了全面调查,将模型分为基础、文本桥接、空间多模态、表观遗传和智能代理五大类,涵盖细胞注释、轨迹预测、药物反应等八项核心任务。研究基于40多个公开数据集,建立了包含生物学理解、可解释性等十个维度的评估体系,为这个快速发展的交叉领域提供了首个系统性分析框架。

AMD:稳健路线图带来资金,资金带来更好的路线图和更多收入

AMD首席执行官苏姿丰在纽约金融分析师日活动中表示,公司已准备好迎接AI浪潮并获得传统企业计算市场更多份额。AMD预计未来3-5年数据中心AI收入复合年增长率将超过80%,服务器CPU收入份额超过50%。公司2025年预期收入约340亿美元,其中数据中心业务160亿美元。MI400系列GPU采用2纳米工艺,Helios机架系统将提供强劲算力支持。

西湖大学团队突破:AI推理模型内存消耗降低50%的秘密武器

西湖大学王欢教授团队联合国际研究机构,针对AI推理模型内存消耗过大的问题,开发了RLKV技术框架。该技术通过强化学习识别推理模型中的关键"推理头",实现20-50%的内存缩减同时保持推理性能。研究发现推理头与检索头功能不同,前者负责维持逻辑连贯性。实验验证了技术在多个数学推理和编程任务中的有效性,为推理模型的大规模应用提供了现实可行的解决方案。

全球数据中心电力需求暴涨,超越电网建设速度

FMC获得FERAM资金以终结Optane的阴霾

AI驱动垂直市场的商业变革与未来机遇

谷歌计划在德州投资400亿美元建设数据中心

AI推动KubeCon NA 2025平台工程复兴浪潮

DeepL CEO:专业翻译服务如何在ChatGPT时代保持竞争优势

提示工程迎来协作提示新技术,让AI成为你的合作伙伴

益博睿的悄然转型:从信用评级到云端AI

特斯拉首次发布更诚实的FSD碰撞数据

GPU巨头正在吞噬超级计算领域,传统存储难以满足需求

MinIO推出EB级ExaPOD存储方案保持AI GPU高效运行

Quantum推出ActiveScale部分对象恢复功能显著提升磁带检索速度