英伟达“GRACE”ARM CPU在HPC领域力压X86

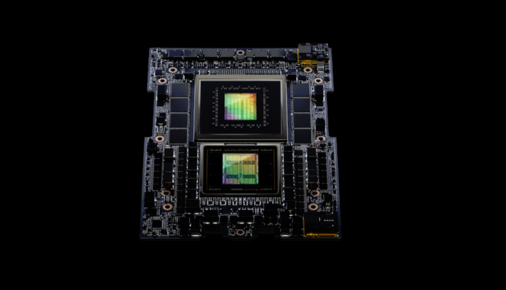

从种种方面来看,英伟达打造的“Grace”CG100服务器处理器都堪称其首款真正的服务器级CPU,也成为扩展“Hopper”GH100 GPU加速器(专为HPC仿真与建模工作负载而设计)内存空间的重要方案。

为提升GPU性能,英伟达选择对HOPPER HBM内存扩容

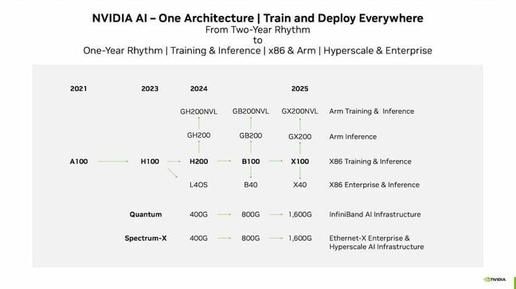

一个月前,在英伟达通过财务会议放出的技术路线图中,可以看到GH200 GPU和H200 GPU加速器将作为“Blackwell”GB100 GPU和B100 GPU之前的过渡产品,而Blackwell家族计划在明年年内推出。

HPE与英伟达携手为AI训练打造“交钥匙”超算方案

HPE与英伟达表示正为客户提供构建模块,可用于组装同布里斯托大学Isambard-AI超级计算机同架构的迷你版本,用以训练生成式AI和深度学习项目。

2023 NVIDIA初创企业展示 · 半程展示圆满收官!

10月19日 - 10月20日,由 NVIDIA 主办的 NVIDIA 初创企业展示 · 半程展示在雅安大数据产业园成功举办。

英伟达继续高歌猛进,AMD与英特尔的AI计划恐难招架

对于过去几代产品而言,两年一更新的速度足以保持竞争优势。但根据本月早些时候投资者们看到的演示文稿,英伟达手中除了B100这张王牌,还有将Arm核心与Blackwell架构匹配打造的全新“超级芯片”,外加L40及L40S的迭代产品。

正式官宣:英伟达与SEEQC成为量子超级计算合作伙伴

英伟达宣布与量子计算芯片厂商SEEQC建立合作,在量子计算机与GPU之间开发首个芯片到芯片的数字链接,并确保与一切量子计算范式相兼容。

销售火爆令英伟达大赚特赚,季度GPU出货量已达“900吨”

Omdia发布统计,认为在一定时期之内,服务器市场将继续以GPU为最主要的核心组件。这家市场研究机构估计,单英伟达H100 GPU这一款产品在今年第二季度的出货量就超过了900吨。

除了英伟达,ARM NEOVERSE V2核心还有没有其他受众?

最近一段时间,Hot Interconnects、Hot Chips、Google Cloud Next和Meta Networking@Scale等重量级会议先后亮相。借此机会,我们打算通过本文以更有条理的方式对资讯亮点做一番整理,聊聊并深入分析我们听到和看到的这些丰富内容。

AMD收购Mipsology加强与英伟达的人工智能推理竞争

Mipsology的团队将帮助AMD提高该公司CPU、GPU和自适应芯片的人工智能软件开发方面的推理能力。

“生成式 AI +多云”构建差异化优势——VMware携手NVIDIA 为企业开启生成式AI新时代

VMware 与NVIDIA 为企业开启生成式AI时代打开了一条快速通道,赋予私有化部署生成式AI的能力,帮助企业获取AI应用的差异化优势。

英伟达升级GRACE-HOPPER GPU内存,着力为大语言模型提供加持

如果情况真如英伟达及其他众多科技企业预料的那样,即大语言模型会成为新的编程模型基础,那么混合CPU-GPU计算引擎就将是新的通用计算平台。

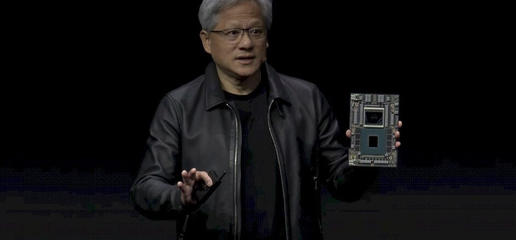

有意见 | AI算力翻倍 英伟达发布GH200超级芯片

英伟达创始人兼首席执行官黄仁勋在SIGGRAPH年会上发布了专为生成式 AI 打造的下一代 GH200 Grace Hopper 平台

英伟达首次推出配备高速内存的升级版GH200 Grace Hopper芯片

英伟达今天首次推出了GH200 Grace Hopper芯片的升级版,它将使企业能够运行更复杂的语言模型。

微软推出配备英伟达GPU的ND H100 v5虚拟机

近日微软表示,ND H100 v5虚拟机系列将上线Azure云平台,为客户训练和运行大模型提供支持。