扫一扫

分享文章到微信

扫一扫

关注官方公众号

至顶头条

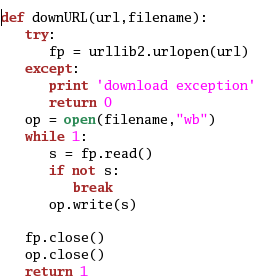

Python有一个urllib的库,可以很方便的从给定的url抓取网页,以下这段程序实现了抓取一个url并存到指定文件的功能:

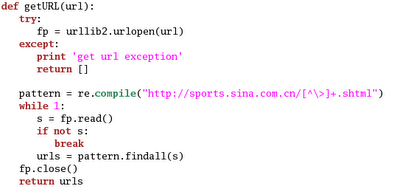

爬虫工作的基本原理就是,给定一个初始的url,下载这个url的网页,然后找出网页上所有满足下载要求的链接,然后把这些链接对应的url下载下来,然后再找下载下来的这些网页的url,我们可以用广度优先搜索实现这个算法,不过,首先得有一个函数找出网页上所有的满足要求的url,下面这个例子用正则表达式找出url.

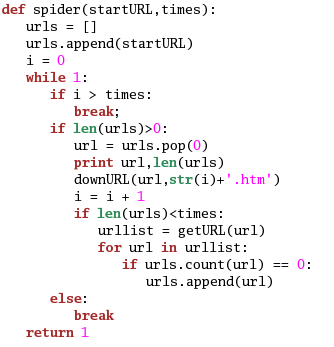

最后就是广度优先搜索了,这个实现起来也很简单:

作者用上面的算法,感觉速度还行,1小时可以抓10000多网页,可以满足小型系统的要求。

【发表评论0条】

如果您非常迫切的想了解IT领域最新产品与技术信息,那么订阅至顶网技术邮件将是您的最佳途径之一。